推翻了第一版,參考了其他分詞程序,重新寫的第二版。

逆向最大匹配中文分詞程序,能實現中英文數字混合分詞。比如能分出這樣的詞:bb霜、3室、樂phone、touch4、mp3、T恤

public class RMM2 extends M

public class RMM2 extends M {

{ public static final HashMap<Character,TreeNode> dic = Dictionary.getRmmdic();

public static final HashMap<Character,TreeNode> dic = Dictionary.getRmmdic();

/**

/** * @return 返回匹配最長詞的長度, 沒有找到返回 0.

* @return 返回匹配最長詞的長度, 沒有找到返回 0. */

*/ public int maxMatch(TreeNode node,char[] sen, int offset)

public int maxMatch(TreeNode node,char[] sen, int offset)  {

{ int idx = offset;

int idx = offset; for(int i=offset; i>=0; i--)

for(int i=offset; i>=0; i--)  {

{ node = node.subNode(sen[i]);

node = node.subNode(sen[i]); if(node != null)

if(node != null)  {

{ if(node.isAlsoLeaf())

if(node.isAlsoLeaf())  idx = i;

idx = i;  }

} else

else  break;

break; }

} return idx ;

return idx ; }

}

public ArrayList<Token> getToken(ArrayList<Sentence> list)

public ArrayList<Token> getToken(ArrayList<Sentence> list) {

{ Collections.reverse(list);

Collections.reverse(list); ArrayList<Token> tokenlist=new ArrayList<Token>();

ArrayList<Token> tokenlist=new ArrayList<Token>(); for(Sentence sen:list)

for(Sentence sen:list) {

{ int i=sen.getText().length-1;

int i=sen.getText().length-1; while(i>-1)

while(i>-1) {

{ TreeNode n=dic.get(sen.getText()[i]);

TreeNode n=dic.get(sen.getText()[i]); if(n!=null)

if(n!=null) {

{ int j=maxMatch(n, sen.getText(),i);

int j=maxMatch(n, sen.getText(),i); if(j<i)

if(j<i) {

{ Token token = new Token(new String(sen.getText(),j,i-j+1),sen.getStartOffset()+j,sen.getStartOffset()+i+1);

Token token = new Token(new String(sen.getText(),j,i-j+1),sen.getStartOffset()+j,sen.getStartOffset()+i+1); tokenlist.add(token);

tokenlist.add(token); i=j-1;

i=j-1; }

} else

else {

{ Token token = new Token(new String(sen.getText(),i,1),sen.getStartOffset()+i,sen.getStartOffset()+i+1);

Token token = new Token(new String(sen.getText(),i,1),sen.getStartOffset()+i,sen.getStartOffset()+i+1); tokenlist.add(token);

tokenlist.add(token); i--;

i--; }

} }

} else

else {

{ Token token = new Token(new String(sen.getText(),i,1),sen.getStartOffset()+i,sen.getStartOffset()+i+1);

Token token = new Token(new String(sen.getText(),i,1),sen.getStartOffset()+i,sen.getStartOffset()+i+1); tokenlist.add(token);

tokenlist.add(token); i--;

i--; }

} }

} }

} Collections.reverse(tokenlist);

Collections.reverse(tokenlist); return tokenlist;

return tokenlist; }

} }

}推翻了第一版,參考了其他分詞程序,重新寫的第二版。

正向最大匹配中文分詞程序,能實現中英文數字混合分詞。比如能分出這樣的詞:bb霜、3室、樂phone、touch4、mp3、T恤

public class FMM2 extends Seg

public class FMM2 extends Seg {

{ public static final HashMap<Character,TreeNode> dic = Dictionary.getFmmdic();

public static final HashMap<Character,TreeNode> dic = Dictionary.getFmmdic();

/**

/** * @return 返回匹配最長詞的長度, 沒有找到返回 0.

* @return 返回匹配最長詞的長度, 沒有找到返回 0. */

*/ public static int maxMatch(TreeNode node,char[] sen, int offset)

public static int maxMatch(TreeNode node,char[] sen, int offset)  {

{ int idx = offset - 1;

int idx = offset - 1; for(int i=offset; i<sen.length; i++)

for(int i=offset; i<sen.length; i++)  {

{ node = node.subNode(sen[i]);

node = node.subNode(sen[i]); if(node != null)

if(node != null)  {

{ if(node.isAlsoLeaf())

if(node.isAlsoLeaf())  idx = i;

idx = i;  }

} else

else  break;

break; }

} return idx + 1;

return idx + 1; }

}

public ArrayList<Token> getToken(ArrayList<Sentence> list)

public ArrayList<Token> getToken(ArrayList<Sentence> list) {

{ ArrayList<Token> tokenlist=new ArrayList<Token>();

ArrayList<Token> tokenlist=new ArrayList<Token>(); for(Sentence sen:list)

for(Sentence sen:list) {

{ int i=0;

int i=0; while(i<sen.getText().length)

while(i<sen.getText().length) {

{ TreeNode n=FMM2.dic.get(sen.getText()[i]);

TreeNode n=FMM2.dic.get(sen.getText()[i]); if(n!=null)

if(n!=null) {

{ int j=FMM2.maxMatch(n, sen.getText(),i);

int j=FMM2.maxMatch(n, sen.getText(),i); if(j>i)

if(j>i) {

{ Token token = new Token(new String(sen.getText(),i,j-i),sen.getStartOffset()+i,sen.getStartOffset()+j);

Token token = new Token(new String(sen.getText(),i,j-i),sen.getStartOffset()+i,sen.getStartOffset()+j); tokenlist.add(token);

tokenlist.add(token); i=j;

i=j; }

} else

else {

{ Token token = new Token(new String(sen.getText(),i,1),sen.getStartOffset()+i,sen.getStartOffset()+i+1);

Token token = new Token(new String(sen.getText(),i,1),sen.getStartOffset()+i,sen.getStartOffset()+i+1); tokenlist.add(token);

tokenlist.add(token); i++;

i++; }

} }

} else

else {

{ Token token = new Token(new String(sen.getText(),i,1),sen.getStartOffset()+i,sen.getStartOffset()+i+1);

Token token = new Token(new String(sen.getText(),i,1),sen.getStartOffset()+i,sen.getStartOffset()+i+1); tokenlist.add(token);

tokenlist.add(token); i++;

i++; }

} }

} }

} return tokenlist;

return tokenlist; }

} }

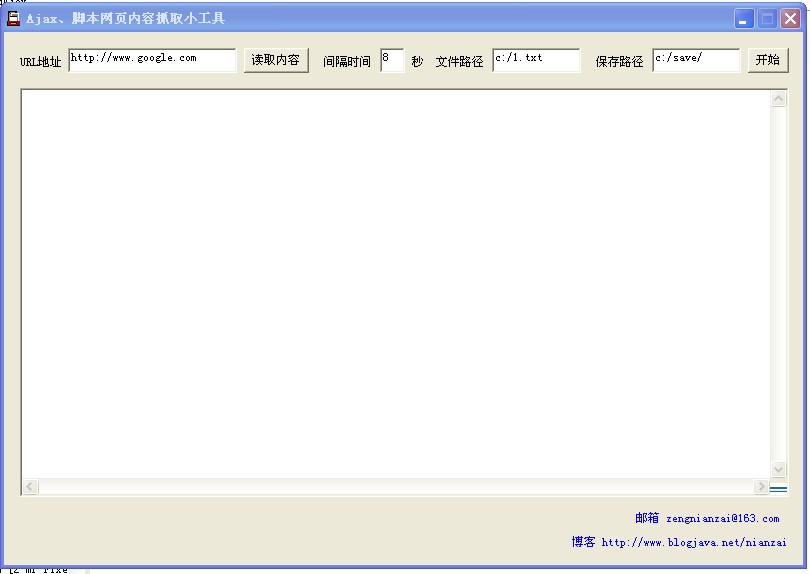

}摘要: Reactor 模式的 JAVA NIO 多線程服務器 Code highlighting produced by Actipro CodeHighlighter (freeware)http://www.CodeHighlighter.com/-->public class MiniServer extends Thread{ &nb... 閱讀全文 摘要: 基于詞典的逆向最大匹配中文分詞算法,能實現中英文數字混合分詞。比如能分出這樣的詞:bb霜、3室、樂phone、touch4、mp3、T恤。實際分詞效果比正向分詞效果好 查看第2版:逆向最大匹配分詞程序,能實現中英文數字混合分詞 (第二版) Code highlighting produced by Actipro CodeHighlighter (freeware) http://w... 閱讀全文 摘要: 基于詞典的正向最大匹配中文分詞算法,能實現中英文數字混合分詞。比如能分出這樣的詞:bb霜、3室、樂phone、touch4、mp3、T恤第一次寫中文分詞程序,歡迎拍磚。查看第2版:正向最大匹配分詞程序,能實現中英文數字混合分詞 (第二版) Code highlighting produced by Actipro CodeHighlighter (freeware)http://www.Code... 閱讀全文 原理:通過瀏覽器去訪問要抓取的Ajax、腳本網頁地址,通過讀取瀏覽器內存document來得到腳本執行以后的網頁內容

1、文件路徑為帶抓取網頁地址,格式如下:

1,http://www.google.com

2,http://www.baidu.com

......

......

2、保存路徑為抓取下來的網頁保存路徑

Ajax、腳本網頁內容抓取小工具 點這下載

blog: http://www.aygfsteel.com/nianzai/

code: http://code.google.com/p/nutla/

一、安裝

1、 安裝虛擬機 Oracle VM VirtualBox4.0.4

2、 在虛擬機下安裝 Red Hat 6.0

3、 安裝jdk jdk-6u24-linux-i586.bin 安裝路徑為:/home/nianzai/jdk1.6.0_24

4、 安裝hadoop hadoop-0.20.2.tar.gz 安裝路徑為:/home/nianzai/hadoop-0.20.2

5、 安裝zookeeper zookeeper-3.3.3.tar.gz 安裝路徑為:/home/nianzai/zookeeper-3.3.3

6、 安裝hbase hbase-0.90.2.tar.gz 安裝路徑為:/home/nianzai/hbase-0.90.2

二、配置

1、Linux配置

ssh-keygen –t rsa -P ''

cd .ssh

cp id_rsa.pub authorized_keys

/etc/hosts里增加 192.168.195.128 master

/etc/profile 里增加

export JAVA_HOME=/home/nianzai/jdk1.6.0_24

export PATH=$PATH:$JAVA_HOME/bin

2、hadoop配置

hadoop-env.sh

JAVA_HOME=/home/nianzai/jdk1.6.0._24

core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/nianzai/hadoop</value>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://master:9000</value>

</property>

</configuration>

hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

mapred-site.xml

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>master:9001</value>

</property>

</configuration>

masters

master

sh hadoop namenode -format

sh start-all.sh

sh hadoop fs -mkdir input

3、zookeeper配置

zoo.cfg

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/home/nianzai/zkdata

clientPort=2181

sh zkServer.sh start

4、hbase配置

hbase-env.sh

export JAVA_HOME=/home/nianzai/jdk1.6.0_24

export HBASE_MANAGES_ZK=false

將hbase0.90.2 lib目錄下hadoop-core-0.20-append-r1056497.jar刪除,替換成hadoop0.20.2 下的hadoop-0.20.2-core.jar

hbase-site.xml

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://master:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.master.port</name>

<value>60000</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>master</value>

</property>

</configuration>

regionservers

master

sh start-hbase.sh

http://code.google.com/p/nutla/

1、概述

不管程序性能有多高,機器處理能力有多強,都會有其極限。能夠快速方便的橫向與縱向擴展是Nut設計最重要的原則,以此原則形成以分布式并行計算為核心的架構設計。以分布式并行計算為核心的架構設計是Nut區別于Solr、Katta的地方。

Nut是一個Lucene+Hadoop分布式并行計算搜索框架,能對千G以上索引提供7*24小時搜索服務。在服務器資源足夠的情況下能達到每秒處理100萬次的搜索請求。

Nut開發環境:jdk1.6.0.23+lucene3.0.3+eclipse3.6.1+hadoop0.20.2+zookeeper3.3.2+hbase0.20.6+memcached+mongodb+linux

2、特新

a、熱插拔

b、可擴展

c、高負載

d、易使用,與現有項目無縫集成

e、支持排序

f、7*24服務

g、失敗轉移

3、搜索流程

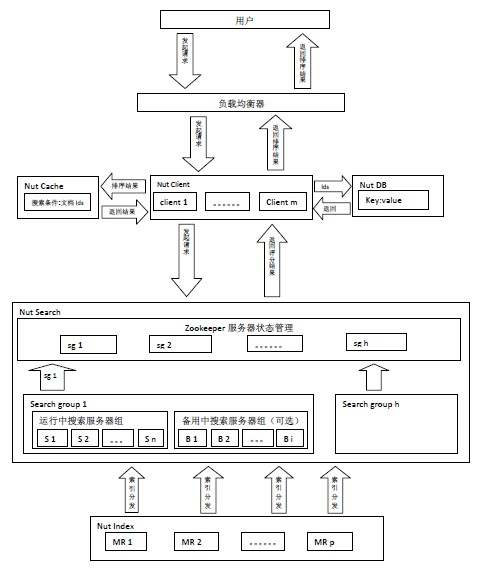

Nut由Index、Search、Client、Cache和DB五部分構成。(Cache實現了對memcached的支持,DB實現了對hbase,mongodb的支持)

Client處理用戶請求和對搜索結果排序。Search對請求進行搜索,Search上只放索引,數據存儲在DB中,Nut將索引和存儲分離。Cache緩存的是搜索條件和結果文檔id。DB存儲著數據,Client根據搜索排序結果,取出當前頁中的文檔id從DB上讀取數據。

用戶發起搜索請求給由Nut Client構成的集群,由某個Nut Client根據搜索條件查詢Cache服務器是否有該緩存,如果有緩存根據緩存的文檔id直接從DB讀取數據,如果沒有緩存將隨機選擇一組搜索服務器組(Search Group i),將查詢條件同時發給該組搜索服務器組里的n臺搜索服務器,搜索服務器將搜索結果返回給Nut Client由其排序,取出當前頁文檔id,將搜索條件和當前文檔id緩存,同時從DB讀取數據。

4、索引流程

Hadoop Mapper/Reducer 建立索引。再將索引從HDFS分發到各個索引服務器。

對索引的更新分為兩種:刪除和添加(更新分解為刪除和添加)。

a、刪除

在HDFS上刪除索引,將生成的*.del文件分發到所有的索引服務器上去或者對HDFS索引目錄刪除索引再分發到對應的索引服務器上去。

b、添加

新添加的數據用另一臺服務器來生成。

刪除和添加步驟可按不同定時策略來實現。

5、Nut分布式并行計算特點

Nut分布式并行計算雖然也是基于M/R模型,但是與Hadoop M/R模型是不同的。在Hadoop M/R模型中 Mapper和Reducer是一個完整的流程,Reducer依賴于Mapper。數據源通過Mapper分發本身就會消耗大量的I/O,并且是消耗I/O最大的部分。所以Hadoop M/R 并發是有限的。

Nut M/R模型是將Mapper和Reducer分離,各自獨立存在。在Nut中 索引以及索引管理 構成M,搜索以及搜索服務器組 構成 R。

以一個分類統計來說明Nut分布式并行計算的流程。假設有10個分類,對任意關鍵詞搜索要求統計出該關鍵詞在這10個分類中的總數。同時假設有10組搜索服務器。索引以及索引管理進行索引數據的Mapper,這塊是后臺獨自運行管理的。Nut Client將這10個分類統計分發到10組搜索服務器上,每組搜索服務器對其中一個分類進行Reducer,并且每組搜索服務器可進行多級Reducer。最后將最終結果返回給Nut Client。

6、設計圖

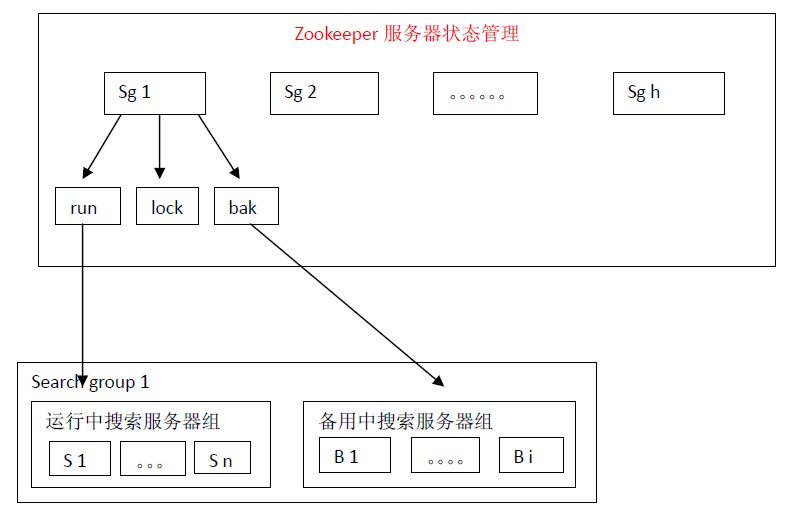

7、Zookeeper服務器狀態管理策略

在架構設計上通過使用多組搜索服務器可以支持每秒處理100萬個搜索請求。

每組搜索服務器能處理的搜索請求數在1萬—1萬5千之間。如果使用100組搜索服務器,理論上每秒可處理100萬個搜索請求。

假如每組搜索服務器有100份索引放在100臺正在運行中搜索服務器(run)上,那么將索引按照如下的方式放在備用中搜索服務器(bak)上:index 1,index 2,index 3,index 4,index 5,index 6,index 7,index 8,index 9,index 10放在B 1 上,index 6,index 7,index 8,index 9,index 10,index 11,index 12,index 13,index 14,index 15放在B 2上。。。。。。index 96,index 97,index 98,index 99,index 100,index 5,index 4,index 3,index 2,index 1放在最后一臺備用搜索服務器上。那么每份索引會存在3臺機器中(1份正在運行中,2份備份中)。

盡管這樣設計每份索引會存在3臺機器中,仍然不是絕對安全的。假如運行中的index 1,index 2,index 3同時宕機的話,那么就會有一份索引搜索服務無法正確啟用。這樣設計,作者認為是在安全性和機器資源兩者之間一個比較適合的方案。

備用中的搜索服務器會定時檢查運行中搜索服務器的狀態。一旦發現與自己索引對應的服務器宕機就會向lock申請分布式鎖,得到分布式鎖的服務器就將自己加入到運行中搜索服務器組,同時從備用搜索服務器組中刪除自己,并停止運行中搜索服務器檢查服務。

為能夠更快速的得到搜索結果,設計上將搜索服務器分優先等級。通常是將最新的數據放在一臺或幾臺內存搜索服務器上。通常情況下前幾頁數據能在這幾臺搜索服務器里搜索到。如果在這幾臺搜索服務器上沒有數據時再向其他舊數據搜索服務器上搜索。

優先搜索等級的邏輯是這樣的:9最大為搜索全部服務器并且9不能作為level標識。當搜索等級level為1,搜索優先級為1的服務器,當level為2時搜索優先級為1和2的服務器,依此類推。

PDF文檔下載

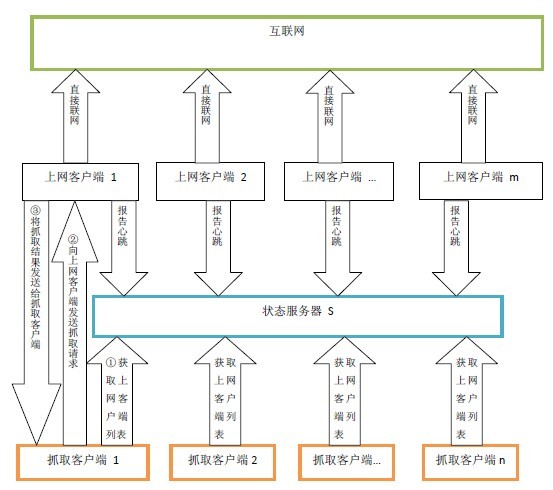

一、 概述

在網頁抓取項目中通常最缺的是IP地址資源,大多數網站對抓取會做些限制(比如同一IP地址的線程數限制,再比如幾分鐘之內同一IP地址的頁面訪問次數限制)。

基于P2P模式的分布式抓取方案是利用分散在各處的可上網機器來抓取網頁,可有效的突破網站限制。

二、設計圖

上網客戶端1 。。。上網客戶端m是分散在各處能直接上網的機器,這些上網客戶端機器定時向狀態服務區報告自己的心跳。

抓取客戶端 1 。。。抓取客戶端 n 是集中放在某處的抓取機器。抓取客戶端機器定時向狀態服務器獲取可用上網客戶端列表,然后抓取客戶端機器直接與上網客戶端建立連接,抓取客戶端機器直接通過上網客戶端來抓取網頁。

三、實現方案

方案一:

在上網客戶端機器上安裝共享上網代理軟件比如ccproxy,抓取客戶端以代理的方式通過上網機器抓取網頁。該方案簡單易行,無技術障礙。

方案二:

開發一套簡化版P2P軟件,抓取客戶端機器將抓取請求分發給客戶端機器,客戶端機器將網頁抓取下來傳回給抓取客戶端機器。該方案復雜些,但可擴展性極強。在掌握了大量上網客戶端機器后完全可以做成云計算進行商業運作。

http://www.aygfsteel.com/nianzai/

http://code.google.com/p/nutla/

一、安裝

1、 安裝虛擬機 vmware6.5.2

2、 在虛擬機下安裝Linux Fedora14

3、 安裝jdk jdk-6u22-linux-i586.bin 安裝路徑為:/home/nianzai/jdk1.6.0_22

4、 安裝hadoop hadoop-0.20.2.tar.gz 安裝路徑為:/home/nianzai/hadoop-0.20.2

5、 安裝zookeeper zookeeper-3.3.1.tar.gz 安裝路徑為:/home/nianzai/zookeeper-3.3.1

6、 安裝hbase hbase-0.20.6.tar.gz 安裝路徑為:/home/nianzai/hbase-0.20.6

二、配置

1、Linux配置

ssh-keygen –t rsa -P ''

cd .ssh

cp id_rsa.pub authorized_keys

/etc/hosts里增加 192.168.195.128 nz 并且將127.0.0.1 改為 192.168.195.128

2、hadoop配置

hadoop-env.sh

JAVA_HOME=/home/nianzai/jdk1.6.0._22

core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/tmp/hadoop-nianzai</value>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://nz:9000</value>

</property>

</configuration>

hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

mapred-site.xml

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>nz:9001</value>

</property>

</configuration>

sh hadoop namenode -format

sh start-all.sh

sh hadoop fs -mkdir input

3、zookeeper配置

zoo.cfg

tickTime=2000

initLimit=10

syncLimit=5

dataDir=/home/nianzai/zkdata

clientPort=2181

sh zkServer.sh start

4、hbase配置

hbase-env.sh

export JAVA_HOME=/home/nianzai/jdk1.6.0_22

export HBASE_MANAGES_ZK=false

hbase-site.xml

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://nz:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.master.port</name>

<value>60000</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>nz</value>

</property>

</configuration>

regionservers

nz

sh start-hbase.sh