本文��p�{转��^��C��务负责�h王计宽分享,原题“转�{push�pȝ��的演�q�之�?#8221;�Q�下文有修订和重新排版�?/p>

1、引�a�

���思义�Q�push���是���是借助厂商通道把消息发送给用户的一�U�方式,一般用于用��L��召回和活动触达,和即旉���讯IM在业务上�E�有区别�Q�但技术逻辑上是盔R��的�Q�不在此处赘�q��?/p>

本文���从0开始讲讲�{转千万��用户量消息推送系�l�的架构演进和�P代过�E�,以及遇到的常见问题的解法�Q�希望能带给你启发�?/strong>

技术交���:

- �U�d��端IM开发入门文章:�?a rel="noopener nofollow" target="_blank" style="color: #1d58d1; text-decoration-line: none;">新手入门一���就够:从零开发移动端IM�?/p>

- 开源IM框架源码�Q?a rel="noopener nofollow" target="_blank" style="color: #1d58d1; text-decoration-line: none;">https://github.com/JackJiang2011/MobileIMSDK�Q?a rel="noopener nofollow" target="_blank" style="color: #1d58d1; text-decoration-line: none;">备用地址�Ҏ���Q?/p>

2、术语解�?/h1>

以下是本文涉及到的一些技术术语的解释�Q?/strong>

- 1�Q?/strong>业务属性:�q�营、业务、功能类推送;

- 2�Q?/em>推送范�? 月活、全量、定向推送、个性化推送;

- 3�Q?/em>目标端:一般是安卓、ios客户端;

- 4�Q?/em>通道�Q�小�c�뀁华为、魅族、apns�{�手机厂商的帔R���q�接�Q?/li>

- 5�Q?/em>token�Q?用于讑֤�的唯一标识�Q�由APP本��n生成�Q?/li>

- 6�Q?/em>devicetoken�Q�用于推送的唯一标识�Q�一般由厂商提供�Q?/li>

- 7�Q?/em>推送量�Q�推送消息的数量�Q?/li>

- 8�Q?/em>到达率:消息到达手机的数�?推送量�Q?/li>

- 9�Q?/em>点击率:用户点击�?推送量�?/li>

3、当前架构概�?/h1>

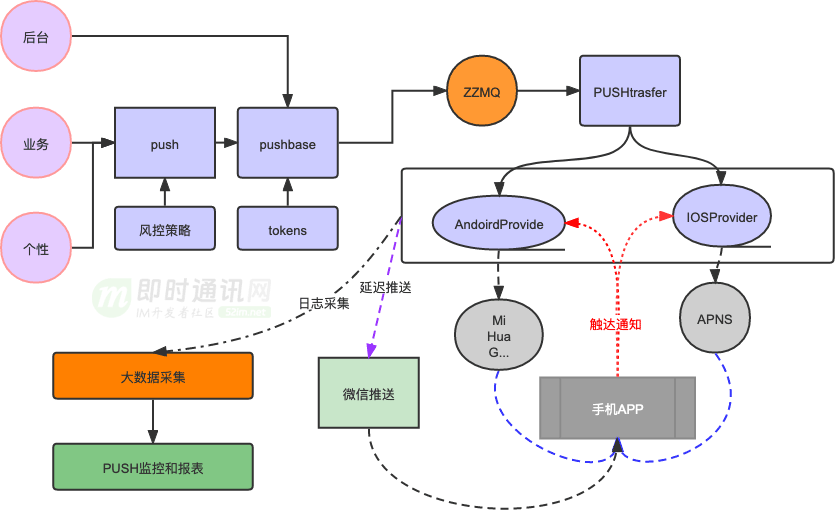

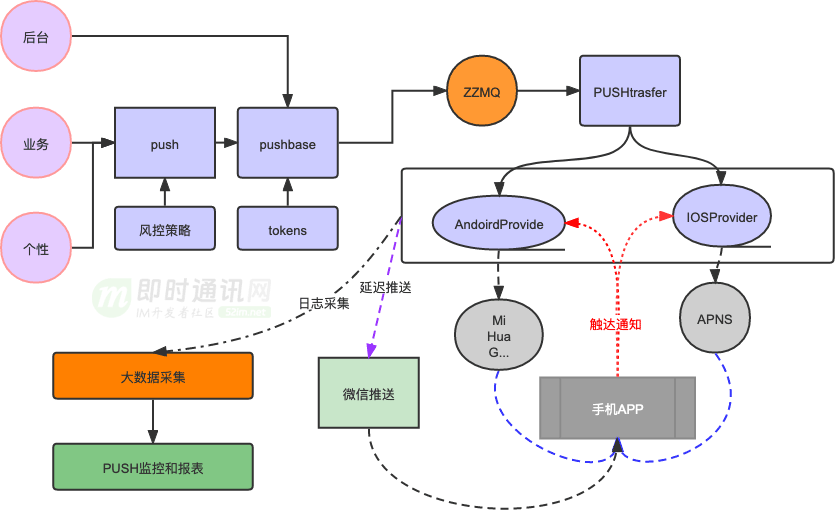

现有的架构支持后台推送、业务推送以及个性化推荐推送�?/p>

现有的架构支持后台推送、业务推送以及个性化推荐推送�?/p>

以下是相��x��送业务的特点�Q?/strong>

- 1�Q?/em>后台推送:一般会有标准的格式�Q�特�Ҏ��旉���短、推送量大,比如8点秒杀�z�d���Q?/li>

- 2�Q?/em>业务推�?�Q�一般都是业务触发,特点是实时性强、优先��高,如订单支付消息;

- 3�Q?/em>个性化推送:�l�常会和用户��d��相关�Q�特�Ҏ���{�略复杂、内容多��P��需要有风控���理�Q�如猜你喜欢�{�推荐策略�?/li>

4、技术背�?#8212;—PM��x��送运营活�?/h1>

步骤�Q?/strong>

- 1�Q?/em>PM从大数据�q�_��上导��Z��部分用户集合�Q?/li>

- 2�Q?/em>RD写程序调用push接口�?/li>

问题�Q?/strong>

- 1�Q?/em>N个PM都有需求,RD..........�Q?/li>

- 2�Q?/em>8�Ҏ��一个突发情况,9�Ҏ��一波;

- 3�Q?/em>每周末都要活动,推送�?/li>

解决�Ҏ���Q?/strong>

- 1�Q?/em>搭徏一个后収ͼ�支持�Ҏ��用户ID上传�Q�解攑ּ�发资源;

- 2�Q?/em>支持按照旉���推送,支持文案可配�Q?/li>

- 3�Q?/em>支持安卓、IOS分端推送�?/li>

遗留的问题:PM上传了一个浏览过手机�cȝ��用户的数据集合,数据量太大,上传���时�?strong>PS�Q?/strong>用户量大概在1000w左右+�Q�大�U?00M左右的文件�?/p>

提示�Q?/strong>

- 1�Q?/em>上传的时间大�U�在1分钟左右�Q?需要联�p�运�l�设�|�最长的链接旉����Q�否则nginx会主动断开�Q?/li>

- 2�Q?/em>上传由同步上传,�Ҏ���q�度条的方式�Q�让上传者可以看到进度;

- 3�Q?/em>上传和数据处理分开�Q�我们当时是边上传,边解析文件比较慢�Q��?/li>

5、希望重大节日能够即旉���知到活跃用�?/h1>5.1 实时�?/h3>

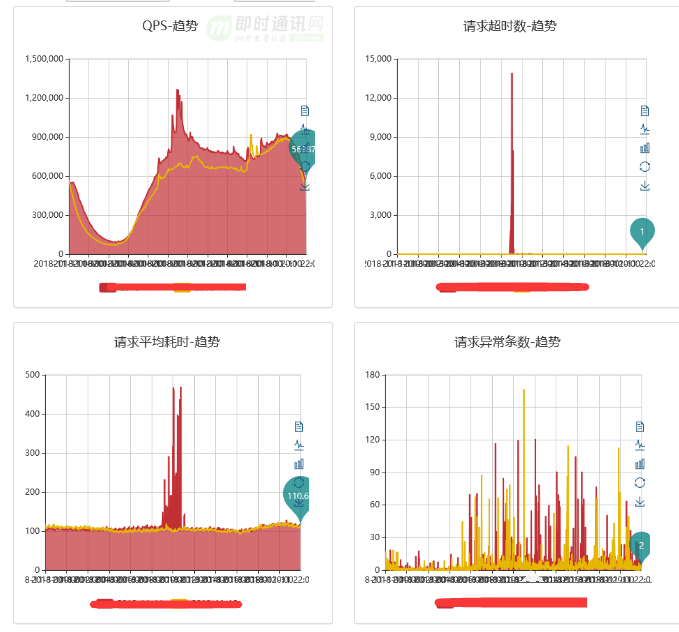

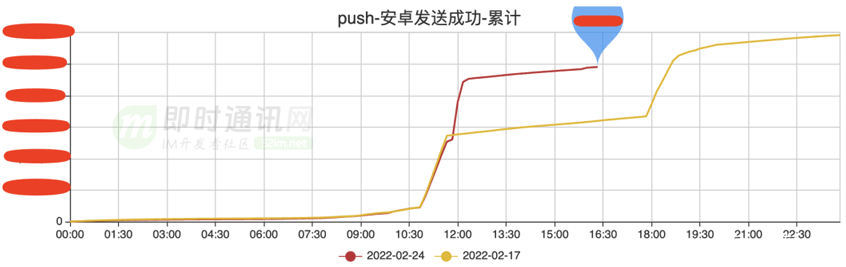

问题描述�Q?/strong>重大节日�Q�推送全量用戗���月�z�R��周�z�L��据,每次仅是文案不同�Q�PM都需要跑大数据系�l�,效率太低�Q�当天数据不可获得,�q�_��推送需�?个多���时�?/p> 要求�Q?/strong> 分析-数据量(�?000w月活��Z���Q�: 分析-性能�Q�以2000w月活��Z���Q�: 隄���分析�Q?/strong> 解决�Ҏ���Q?/strong> 最�l�选择redis的zset�q�行存储�?/p> 首先分析之前之所以慢的原因: 解决�Ҏ���Q?/strong> 注意�Q?/strong>iOS通道�Q�我们用的pushy开源工��P��特定情况下无法持�l�推送消息,需要定时检查,重新创徏通道�?/p> 最后的效果�Q?/strong>push推送的QPS辑ֈ�3w+�Q�推送能力提升的同时�Q�也引发了以下问题�?/p> 问题描述�Q?/strong>当push的推送能力上��M��之后�Q?用户的瞬时访问问题随之而来 push落地效果�Q?/strong> 解决办法�Q?/strong> 问题描述�Q?/strong>有一天晚�?�Ҏ��送了一个运营类的push,发现居然点击率超�U�高�Q�是文案优秀�Q�还是流量高峎ͼ� 要求�Q?/strong>存在多个推送文案,�pȝ��能够择优选择点击率最好的�q�行推送? 解决方式�Q?/strong>加入AB���的能力�Q�先�q�行���量用户推送,�Ҏ��AB的效果,择优推�? 新的问题�Q?/strong>之前安卓的通道我们仅有���米通道+个推�Q�个推达到率一般,做托底)�Q?如果我们向华为手机推送消息,也是通过���米通道是很隑ֈ�辄����?/p> 要求�Q?/strong> 解决方式�Q?/strong> 效果�Q?/strong>当年�l�计能够提高10%的达到率�?/p> 一般的监控�l�度包含�Q?/strong> 现状�Q?/strong> 提高速度�Q?/strong>预加�?�~�存+多线�E?合理的数据结�?扚w��处理+合理布局+�Ҏ��埋点�?/p> 折中�Ҏ���Q?/strong>异步上传、限���控制、降�U�处理、分层解耦、补偉K��知�?/p> [1] 极光推送系�l�大规模高�ƈ发架构的技术实践分�?/a> [2] ��族2500万长�q�接的实时消息推送架构的技术实践分�?/a> [3] 专访��族架构师:���量长连接的实时消息推送系�l�的心得体会 [4] ��Z��WebSocket实现Hybrid�U�d��应用的消息推送实�?含代码示�? [5] 一个基于长�q�接的安全可扩展的订�?推送服务实现思�\ [6] 实践分��n�Q�如何构��Z��套高可用的移动端消息推送系�l�? [7] Go语言构徏千万�U�在�U�的高�ƈ发消息推送系�l�实�?来自360公司) [8] 腾讯信鸽技术分享:百亿�U�实时消息推送的实战�l�验 [9] 京东京麦商家开攑��^台的消息推送架构演�q�之�?/a> [10] 技术干货:从零开始,教你设计一个百万��的消息推送系�l?/a> [11] 爱奇艺WebSocket实时推送网��x��术实�?/a> [12] 喜马拉雅亿��用户量的��ȝ��消息推送系�l�架构设计实�?/a> [13] 消息推送技术干货:���团实时消息推送服务的技术演�q�之�?/a> [14] 揭秘vivo百亿�U�厂商消息推送��^台的高可用技术实�?/a> [15] 得物从零构徏亿��消息推送系�l�的送达�E�_��性监控体�p�L��术实�?/a> [16] B站千万��长连接实时消息系�l�的架构设计与实�?/a> �Q�本文已同步发布于:http://www.52im.net/thread-4852-1-1.html�Q?/a>

5.2 如何提高发送性能

5.3 业务服务器扛不住瞬时���量

6、AB实验�?/h1>

7、整合全部手机厂商��ROOM推送通道

8、消息送达监控

9�?本文���结

10�?参考资�?/h1>

RainbowTalk是一套基于MobileIMSDK的��品��鸿蒙NEXT端IM�pȝ���Q�目前已正式发布。纯ArkTS、从零编写,无套壟뀁没走捷径,每一行代码都�?#8220;�U?#8221;�Q?span style="color: #888888;">详见�Q��?/span>RainbowTalk详细介绍�?/span>�Q��?/p> MobileIMSDK是一整套开源IM��x��通讯框架�Q�历�l?0�q�_�����轻量��、高度提��|��一套API优雅支持 UDP 、TCP 、WebSocket 三种协议�Q�支�?iOS、Android、H5、标准Java、小�E�序、Uniapp、�`蒙NEXT�Q�服务端��Z��Netty�~�写�?br /> 1�Q?/em>支持文本消息、语音留�a�消息、图片消息、大文�g消息�Q?span style="color: #808080;">支持断点上传 RainbowTalk�U�上版本目前仅作演示和研�I�之用,�q�行环境配置最���化�Q�仅1�?G�?MB带宽�Q�,请客观评估�?/p> �Q?strong>本文内容引用自:http://www.52im.net/thread-4822-1-1.html�Q?/p>

MobileIMSDK工程的开源地址是:

2、功能简�?/h2>

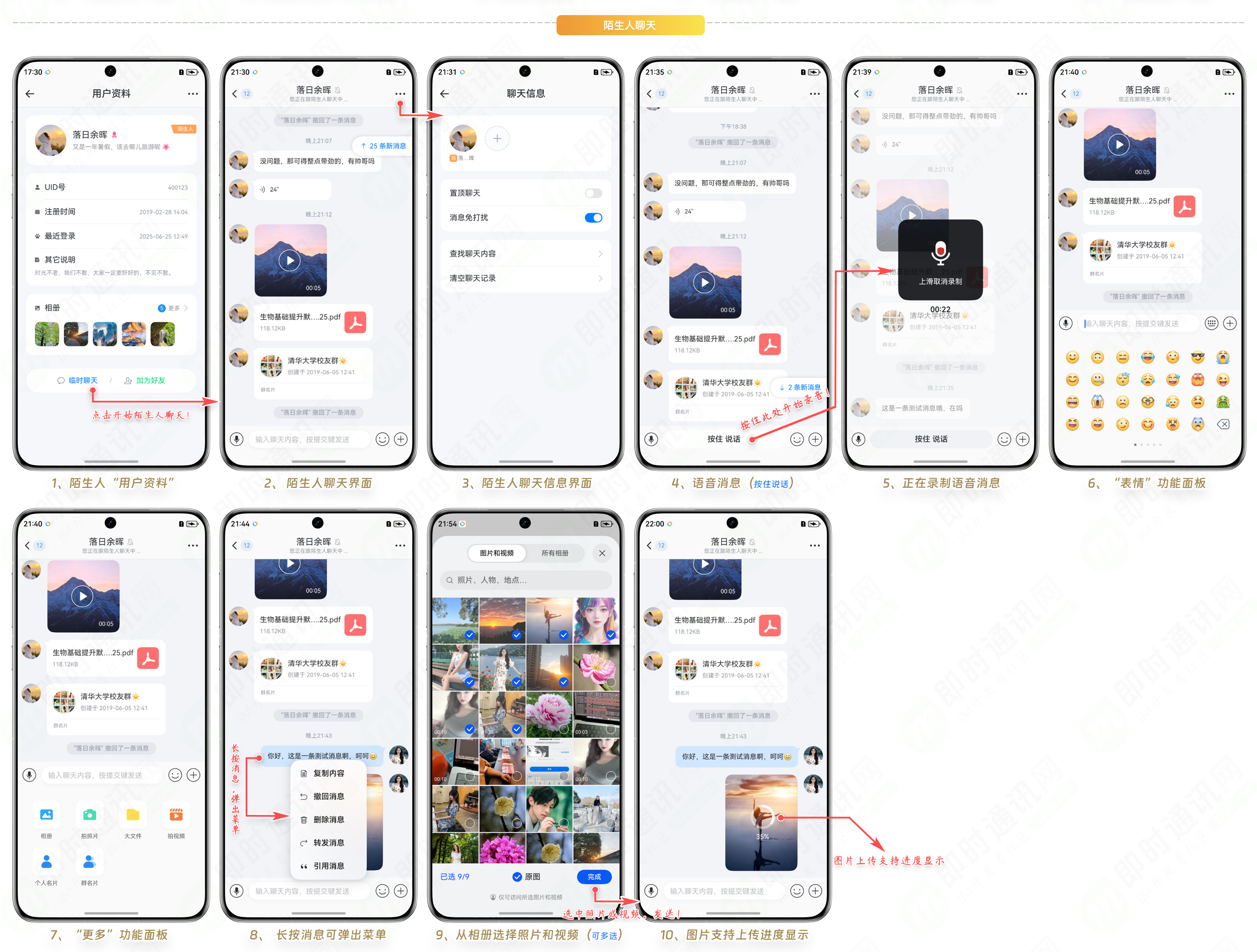

2�Q?/em>支持一对一陌生�����天模式;

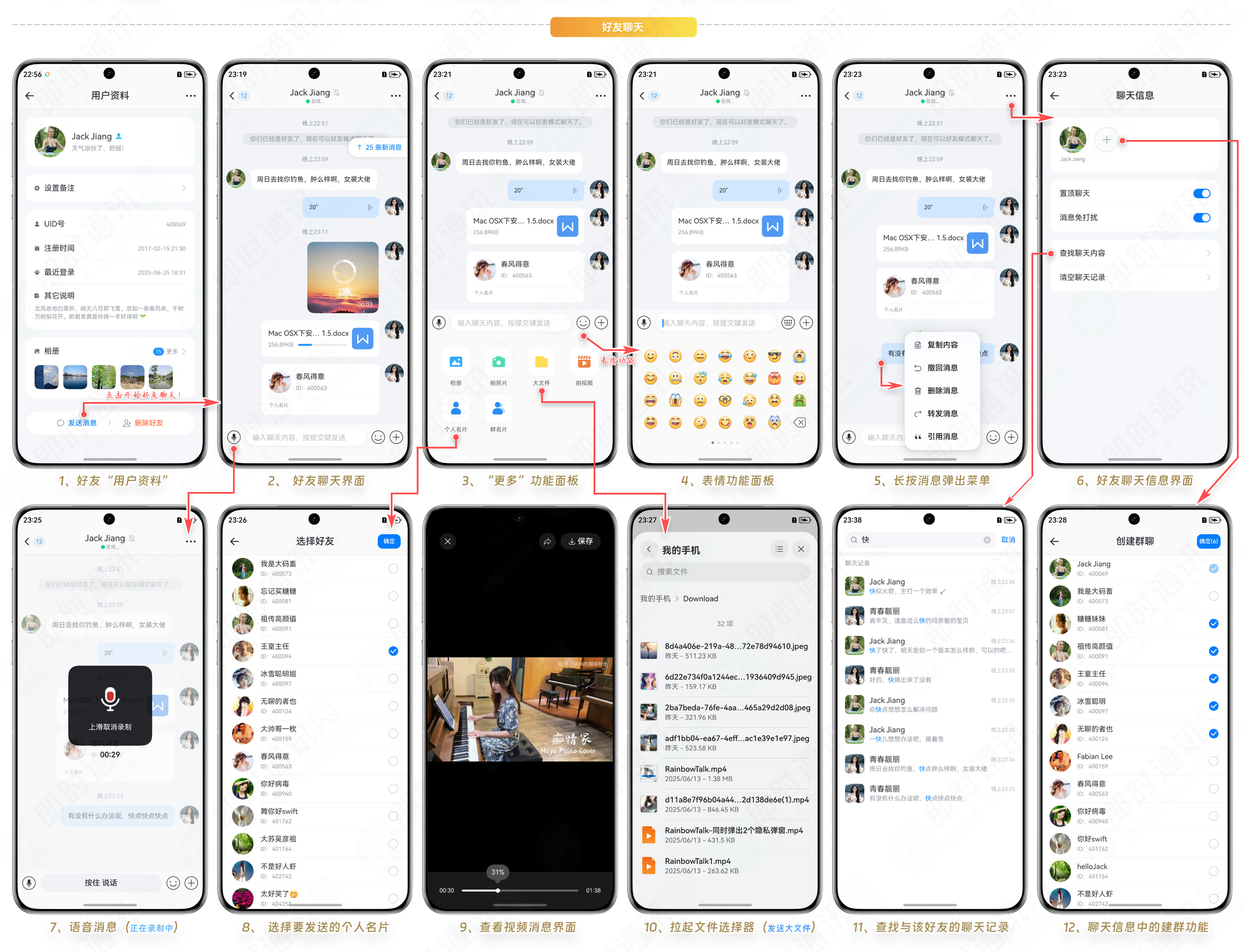

3�Q?/em>支持一对一正式好友聊天模式�Q?br />4�Q?/em>支持多对多群聊聊天模式;

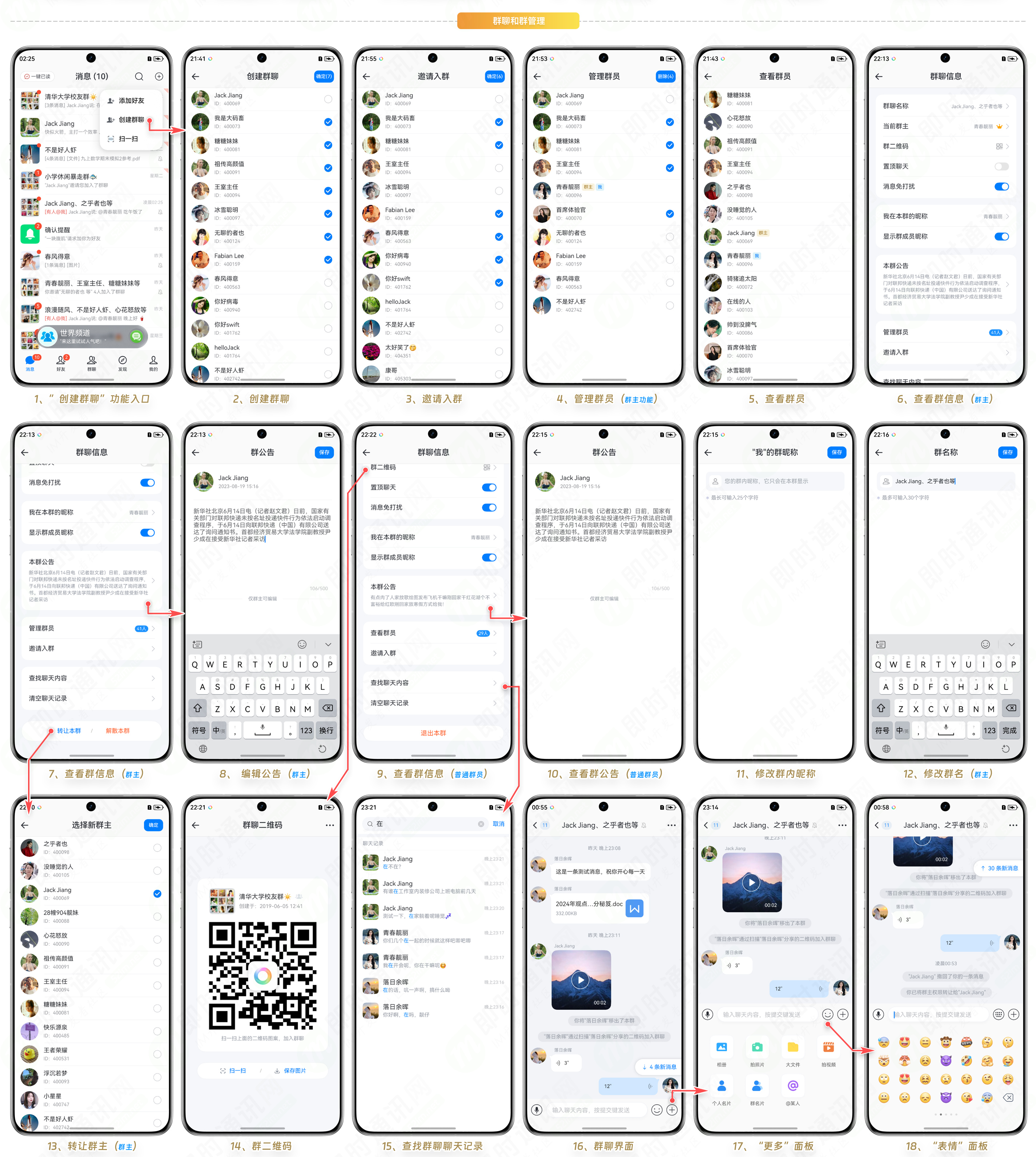

5�Q?/em>完善的群�l�信息管理:建群、退���、解散、�{让、邀诗���踢人、群公告�{�;

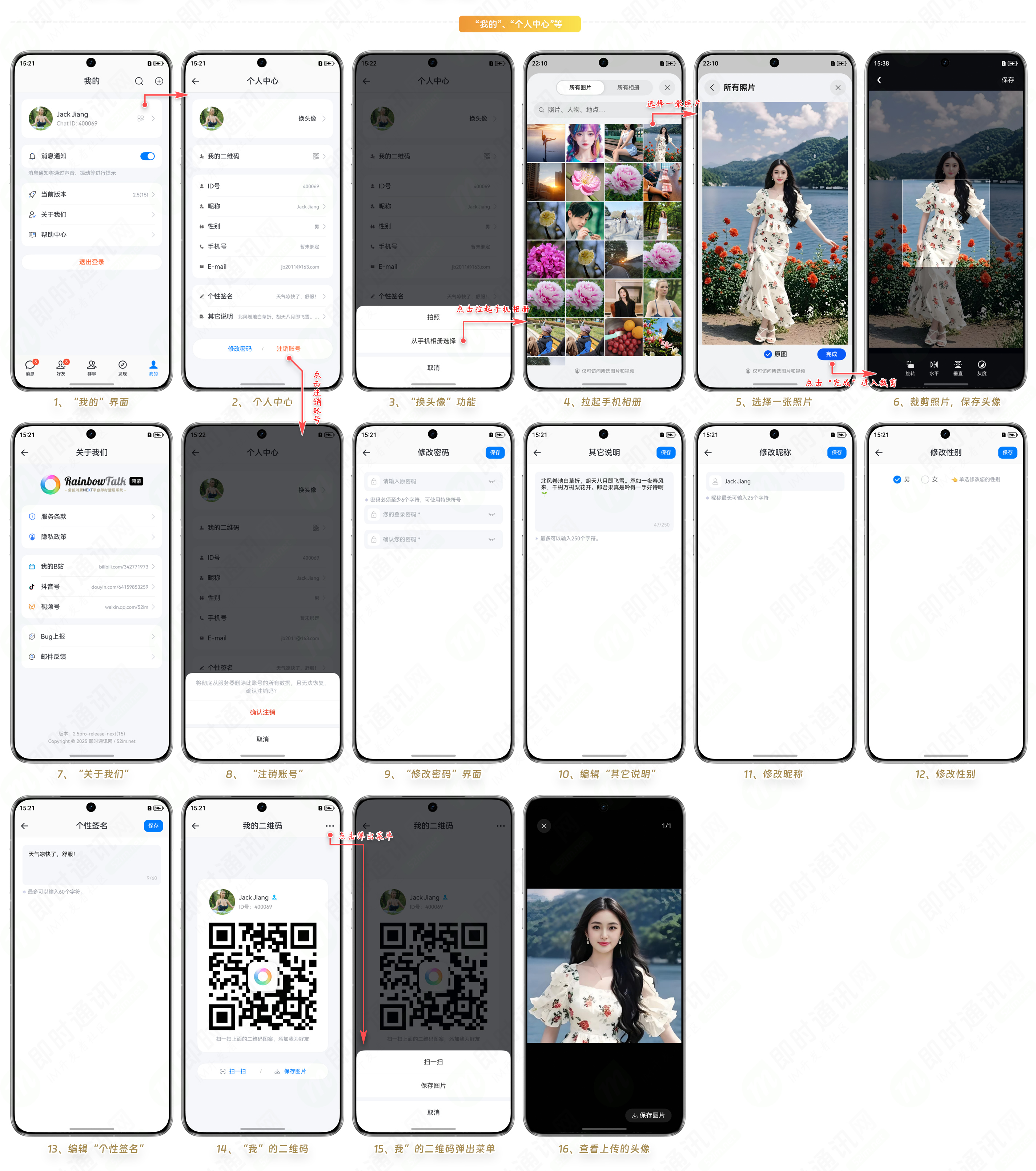

6�Q?/em>完整的注册、登陆(同时支持手机验证码登录和密码��d���Q�、密码找回等功能闭环�Q?br />7�Q?/em>个�h中心功能�Q�改基本信息、改个性签名、改头像、改密码�{�;

8�Q?/em>支持个�h相册查看�Q?br />9�Q?/em>完整的离�U�消�?指��o拉取机制�Q?br />10�Q?/em>完整的本地消�?指��o�~�存机制�Q�节省网�l�流量;

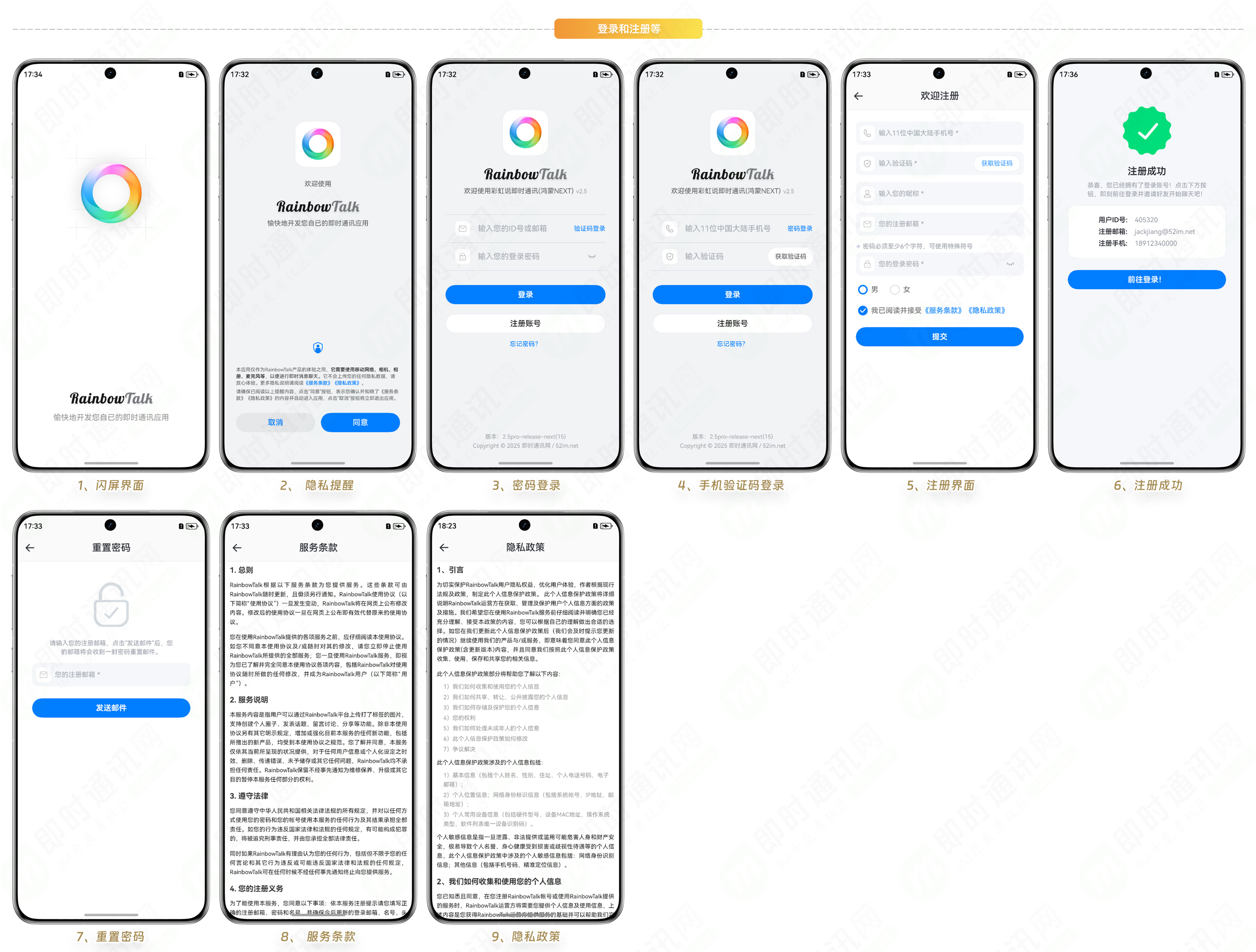

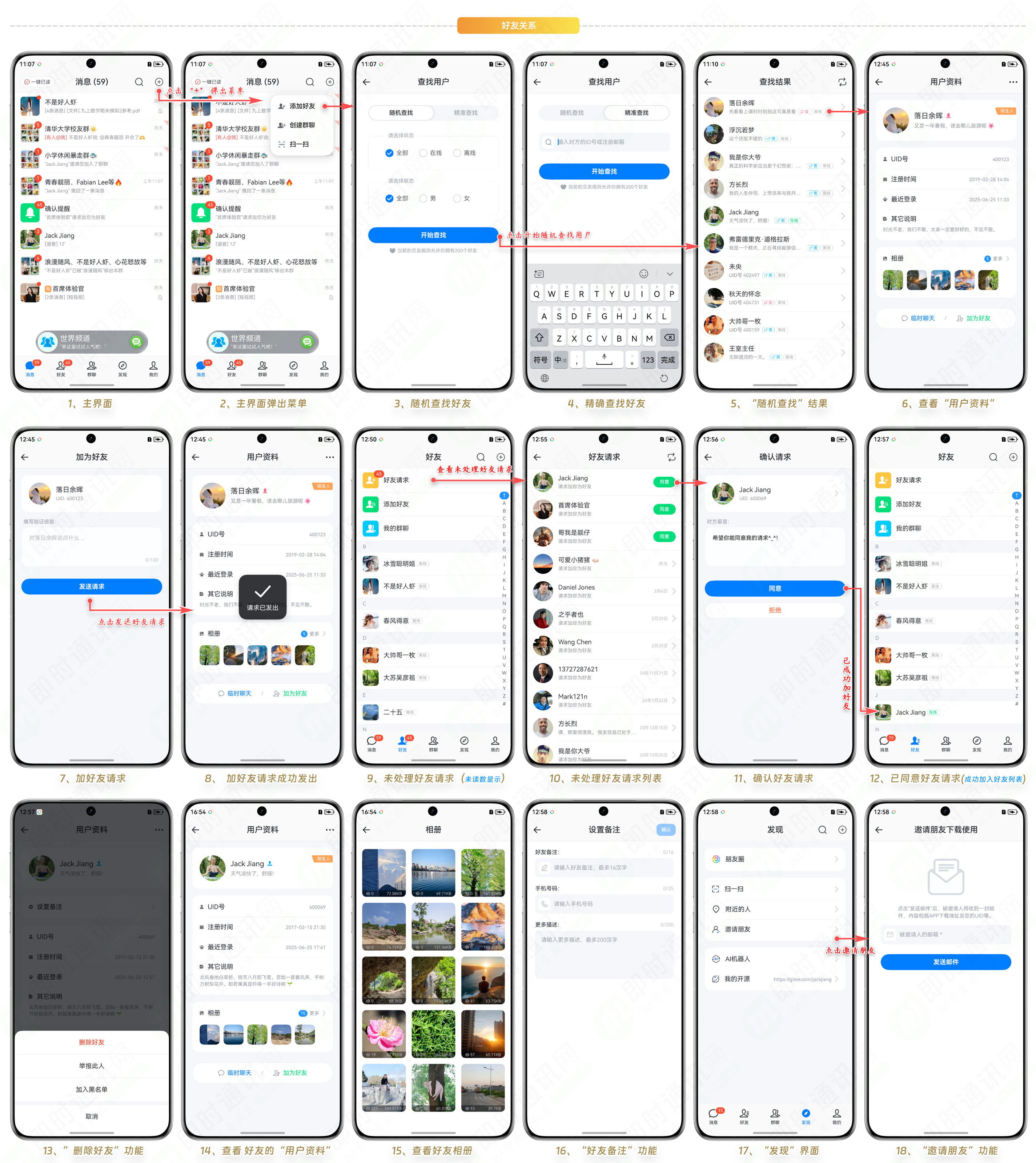

11�Q?/em>完整的富媒体文�g�Q?span style="color: #808080;">语音、大文�g、图片、短视频�Q�缓存机�Ӟ��节省�|�络���量�Q?br />12�Q?/em>完整的好友关�pȝ��理:查找好友、发�����求、处理请求、删除好友、好友备注等�Q?br />13�Q?/em>其它未提及的功能和特性请自行下蝲体验�?/p>3、登陆和注册�{?/h2>

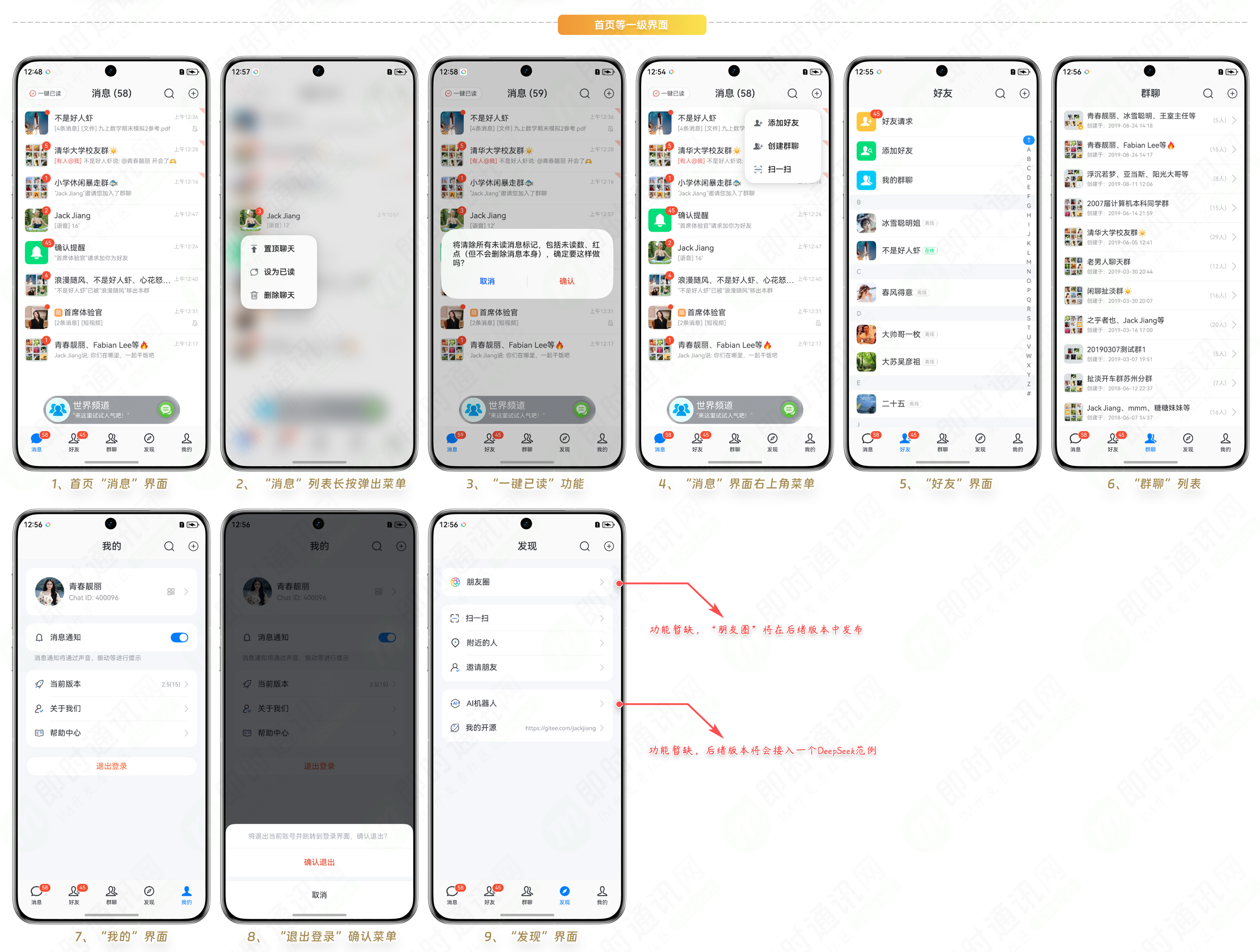

4、首��늭�主要界面

5�?#8220;我的”�?#8220;个�h中心”�{�页�?/h2>

6、好友关�pȝ��

7、陌生�h聊天

8、好友聊�?/h2>

9、世界频道聊�?/h2>

10、群聊和���管�?/h2>

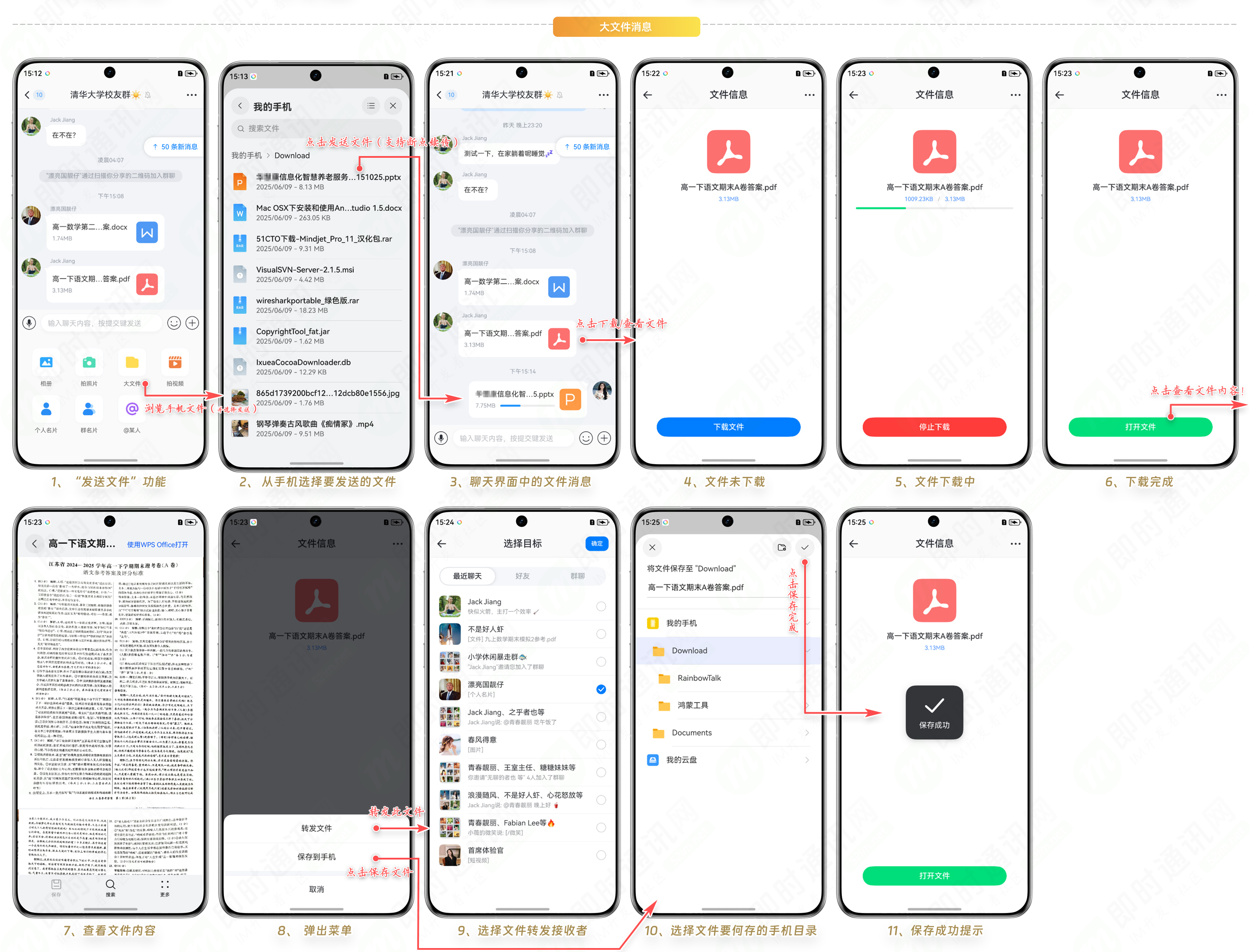

11、大文�g消息

12、短视频消息

13�?#8220;个�h名片”消息

14�?#8220;���名�?#8221;功能

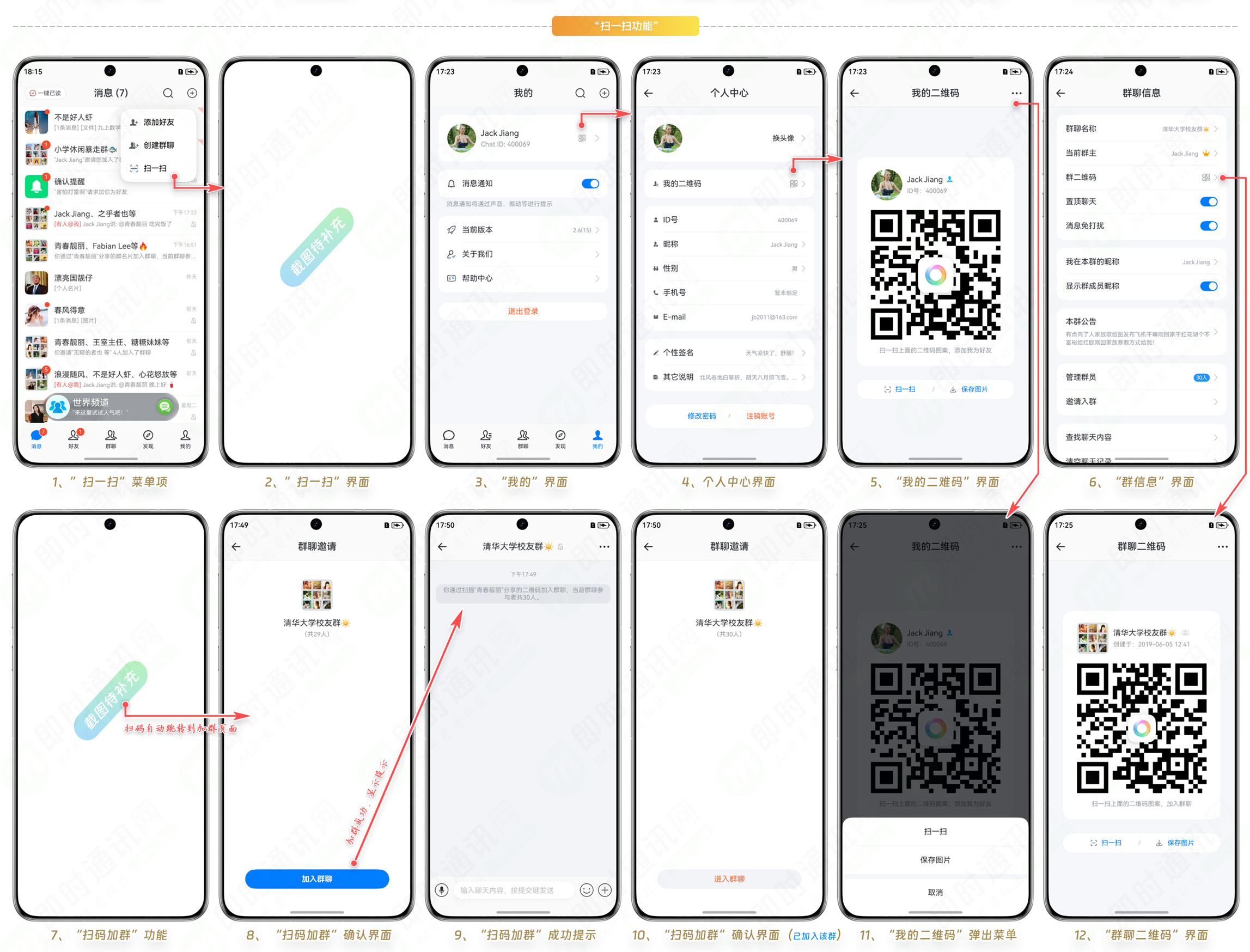

15�?#8220;扫一�?#8221;功能

16�?#8220;搜烦”功能

17�?#8220;消息转发”功能

18�?#8220;消息引用”功能

19�?#8220;@”功能

20�?#8220;消息撤回”功能