一、 環(huán)境介紹

模擬環(huán)境使用三臺(tái)rhel5.8 32bit,各自IP和主機(jī)名如下:

- IP 主機(jī)名

- 192.168.88.253 none.mos.com

- 192.168.88.129 lab1.mos.com

- 192.168.88.130 lab2.mos.com

其中

- none.mos.com負(fù)責(zé)任務(wù)管理和數(shù)據(jù)名稱節(jié)點(diǎn),在生產(chǎn)環(huán)境中,建議將此兩項(xiàng)分開;

- lab1.mos.com為第二名稱節(jié)點(diǎn),其并不提供名稱節(jié)點(diǎn)的功能,但默認(rèn)情況下,負(fù)責(zé)周期性的將編輯日志合并至名稱節(jié)點(diǎn),并自己也保存一份,其提供了名稱節(jié)點(diǎn)的冗余,但其數(shù)據(jù)依然落后于名稱節(jié)點(diǎn);

- lab3.mos.com為實(shí)際數(shù)據(jù)存儲(chǔ)節(jié)點(diǎn)和任務(wù)執(zhí)行節(jié)點(diǎn)。

使用的軟件版本及下載地址:

- JDK: jdk-7u5-linux-i586.rpm

- 下載地址: http://www.oracle.com/technetwork/java/javase/downloads/java-archive-downloads-javase7-521261.html

- Hadoop: hadoop-0.20.2-cdh3u5.tar.gz

- 下載地址: http://hadoop.apache.org/releases.html

二、 準(zhǔn)備工作

2.1 修改每個(gè)主機(jī)的/etc/hosts文件如下:

- 192.168.88.253 none.mos.com none

- 192.168.88.129 lab1.mos.com lab1

- 192.168.88.130 lab2.mos.com lab2

2.2 在集群的每個(gè)節(jié)點(diǎn)建立用于運(yùn)行hadoop的用戶及設(shè)定密碼

- # useradd hduser && echo "redhat" | passwd --stdin hduser

2.3 為master節(jié)點(diǎn)的hduser用戶能夠管理并監(jiān)控其他節(jié)點(diǎn),在none節(jié)點(diǎn)做如下操作。

- # su – hduser

- $ ssh-keygen -t rsa -P ''

- $ ssh-copy-id -i .ssh/id_rsa.pub hduser@lab1

- $ ssh-copy-id -i .ssh/id_rsa.pub hduser@lab2

2.4 確保每個(gè)節(jié)點(diǎn)時(shí)間的一致性,并清空iptables和關(guān)閉selinux,此處操作略

三、 配置hadoop運(yùn)行所需的java環(huán)境,此操作需在每個(gè)節(jié)點(diǎn)執(zhí)行一遍。

3.1 安裝jdk

- # rpm -ivh ~/root/Download/jdk-7u5-linux-i586.rpm

3.2 配置java環(huán)境變量

- # vim /etc/profile.d/java.sh

- JAVA_HOME=/usr/java/latest

- PATH=$JAVA_HOME/bin:$PATH

- export JAVA_HOME PATH

3.3 使剛才配置的環(huán)境其生效(或重新登陸控制臺(tái)亦可)

- # source /etc/profile.d/java.sh

3.4 測試java環(huán)境是否OK

- # su – hduser

- $ java –version

- java version "1.7.0_05"

- Java(TM) SE Runtime Environment (build 1.7.0_05-b05)

- Java HotSpot(TM) Server VM (build 23.1-b03, mixed mode)

四、 安裝Hadoop,此步驟操作略長,但也需在每個(gè)節(jié)點(diǎn)執(zhí)行。

4.1 解壓至/usr/local目錄,并做軟件鏈接使其易于訪問

- # tar xf ~/Download/hadoop-0.20.2-cdh3u5.tar.gz –C /usr/local/

- # ln -sv /usr/local/hadoop-0.20.2-cdh3u5 /usr/local/hadoop

4.2 修改hadoop目錄的屬主屬組,并配置hadoop環(huán)境變量

- # chown -R hduser. /usr/local/hadoop-0.20.2-cdh3u5

- # vim /etc/profile.d/hadoop.sh

- HADOOP_HOME=/usr/local/hadoop

- PATH=$HADOOP_HOME/bin:$PATH

- export HADOOP_HOME PATH

4.3 使hadoop環(huán)境變量生效并使用hduser測試其是否就緒

- # source /etc/profile.d/hadoop.sh

- # su – hduser

- $ hadoop version

- Subversion git://ubuntu-slave02/var/lib/jenkins/workspace/CDH3u5-Full-RC/build/cdh3/hadoop20/0.20.2-cdh3u5/source -r 30233064aaf5f2492bc687d61d72956876102109

- Compiled by jenkins on Fri Oct 5 17:21:34 PDT 2012

- From source with checksum de1770d69aa93107a133657faa8ef467

五、 配置Hadoop,集群中每個(gè)節(jié)點(diǎn)只能通過配置文件來得知自身的角色,因此,以下配置需在每個(gè)節(jié)點(diǎn)都做同樣修改。

5.1 定義第二名稱節(jié)點(diǎn)的主機(jī)名或IP地址

- # echo ‘lab1.mos.com’ > /usr/local/hadoop/conf/masters

5.2 定義數(shù)據(jù)節(jié)點(diǎn)和任務(wù)執(zhí)行節(jié)點(diǎn),筆者這里只有一個(gè),而生成環(huán)境中,數(shù)據(jù)節(jié)點(diǎn)一般最少3個(gè)以上。

- # echo ‘lab2.mos.com’ > /usr/local/hadoop/conf/slaves

5.3 定義系統(tǒng)級別的參數(shù)如下:

- # vim /usr/local/hadoop/conf/core-site.xml

- <?xml version="1.0"?>

- <?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

- <!-- Put site-specific property overrides in this file. -->

- <configuration>

- <!-- 定義hadoop的分布式文件系統(tǒng)hdfs的名稱節(jié)點(diǎn)。-->

- <property>

- <name>fs.default.name</name>

- <value>hdfs://none.mos.com:8020</value>

- </property>

- <!--定義臨時(shí)文件的位置,需確保此目錄存在,且hadoop的執(zhí)行用戶hduser對其有足夠的權(quán)限. -->

- <property>

- <name>hadoop.tmp.dir</name>

- <value>/hadoop/temp</value>

- </property>

- <!--定義回收站,可不定義,設(shè)置在hdfs中刪除的文件先放在回收站內(nèi),超時(shí)才會(huì)被刪除,時(shí)間單位為分鐘,筆者此處定義為100小時(shí)。-->

- <property>

- <name>fs.trash.interval</name>

- <value>6000</value>

- </property>

- </configuration>

5.4 定義任務(wù)管理管理節(jié)點(diǎn)

- # vim /usr/local/hadoop/conf/mapred-site.xml

- <?xml version="1.0"?>

- <?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

- <!-- Put site-specific property overrides in this file. -->

- <configuration>

- <property>

- <name>mapred.job.tracker</name>

- <value>none.mos.com:8021</value>

- </property>

- </configuration>

5.5 定義hadoop的分布式文件系統(tǒng)相關(guān)屬性

- # vim /usr/local/hadoop/conf/hdfs-site.xml

- <?xml version="1.0"?>

- <?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

- <!-- Put site-specific property overrides in this file. -->

- <configuration>

- <!-- 為了保證數(shù)據(jù)的冗余,定義切割后的數(shù)據(jù)塊在幾個(gè)節(jié)點(diǎn)上存儲(chǔ),生產(chǎn)環(huán)境中,建議最少3份以上,筆者這里就一個(gè)數(shù)據(jù)節(jié)點(diǎn),因此,此處為1即可-->

- <property>

- <name>dfs.replication</name>

- <value>1</value>

- </property>

- <!-- 數(shù)據(jù)名稱節(jié)點(diǎn)用于存儲(chǔ)HDFS文件數(shù)據(jù)塊的本地目錄,存儲(chǔ)多份時(shí),可寫多個(gè)路徑,以逗號(hào)隔開即可-->

- <property>

- <name>dfs.data.dir</name>

- <value>/hadoop/data</value>

- <final>ture</final>

- </property>

- <!-- 數(shù)據(jù)節(jié)點(diǎn)用于存儲(chǔ)名稱空間和事務(wù)日志的本地文件系統(tǒng)路徑,存儲(chǔ)多份時(shí),可寫多個(gè)路徑,以逗號(hào)隔開即可 -->

- <property>

- <name>dfs.name.dir</name>

- <value>/hadoop/name</value>

- <final>ture</final>

- </property>

- <!-- 用于定義HDFS元數(shù)據(jù)冗余的復(fù)制到這個(gè)目錄 -->

- <property>

- <name>fs.checkpoint.dir</name>

- <value>/hadoop/namesecondary</value>

- <final>ture</final>

- </property>

- </configuration>

5.6 創(chuàng)建hadoop配置中定義的目錄,且給予相應(yīng)的權(quán)限

- # mkdir -pv /hadoop/temp && chown -R hduser. /hadoop

六、 格式化hadoop的分布式文件系統(tǒng)(HDFS),并檢測hadoop是否就緒。

6.1 以hduser的身份格式,切記一定要將第五步的操作在三個(gè)節(jié)點(diǎn)全部完成

- # su - hduser

- $ hadoop namenode –format

- 出現(xiàn)“Storage directory /hadoop/temp/dfs/name has been successfully formatted”此行,才表示格式化成功,否則需檢查是否配置出錯(cuò)。

6.2 以hduser的身份啟動(dòng)hadoop

- $ start-all.sh

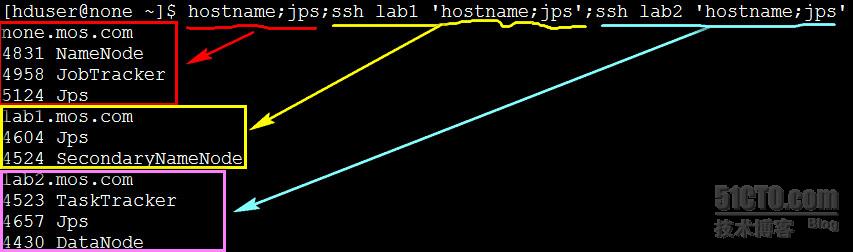

6.3 使用jps在每個(gè)節(jié)點(diǎn),檢查是否啟動(dòng)正常.

七、 使用hadoop提供的字符統(tǒng)計(jì)應(yīng)用程序算法樣例做簡單的計(jì)算實(shí)現(xiàn)

7.1 在hadoop的分布式文件系統(tǒng)(hdfs)中創(chuàng)建目錄,并上傳要計(jì)算的文件

- $ hadoop fs -mkdir mos-test

- $ hadoop fs -put /etc/services mos-test

7.2 調(diào)用hadoop提供的字符統(tǒng)計(jì)程序,計(jì)算上傳的services文件的每個(gè)字符個(gè)數(shù),并輸出到hdfs的test-out目錄中,此目錄hadoop會(huì)自行創(chuàng)建。

- $ hadoop jar /usr/local/hadoop/hadoop-examples-0.20.2-cdh3u5.jar wordcount mos-test test-out

7.3 等命令執(zhí)行完成后,下載執(zhí)行結(jié)果到本地當(dāng)前目錄,并查看相關(guān)內(nèi)容

- $ hadoop fs -get ./test-out/part-r-00000 ./

- $ head part-r-00000

7.4 也可不用下載直接查看HDFS的文件或目錄

- $ hadoop fs –ls / #查看hdfs的根位置

- $ hadoop fs –cat /user/hduser/test-out/part-r-00000 #不下載直接查看計(jì)算結(jié)果

- Ps: hadoop fs命令的相關(guān)用法,可通過:hadoop fs --help獲得

到此為止,一個(gè)簡單的分布式hadoop并行運(yùn)算集群已經(jīng)已然完成,哈哈,是不是很簡單,但是需要說明的是,各位其實(shí)也看到了,并且想必各位也充滿了各種 疑惑:這些命名神馬的怎么這么奇怪?hdfs是怎么工作的?數(shù)據(jù)怎么分開存儲(chǔ)的?數(shù)據(jù)怎么在被切開存儲(chǔ)后還能計(jì)算?各個(gè)節(jié)點(diǎn)的高可用怎么實(shí)現(xiàn)?如果需要更 為復(fù)雜的運(yùn)算怎么處理等等?相關(guān)內(nèi)容,筆者也在慢慢的整理和學(xué)習(xí),敬請關(guān)注哈。

補(bǔ)充一點(diǎn)相關(guān)知識(shí):

當(dāng)hadoop正常啟動(dòng)后,不同的節(jié)點(diǎn),會(huì)開放不同的幾個(gè)端口,可以直接通過web頁面查看其相關(guān)信息的端口,實(shí)際上,開放的端口 遠(yuǎn)不止這些,(詳情可以通過 netstat -tnlp|grep java)查看, 但是只有這些可以通過web直接打開查看。具體如下:

- 端口 工作節(jié)點(diǎn) 本此實(shí)驗(yàn)的web查方式

- 0.0.0.0:50030 任務(wù)管理節(jié)點(diǎn)(JobTracker) 192.168.88.253:5030

- 0.0.0.0:50070 HDFS的數(shù)據(jù)名稱節(jié)點(diǎn)(NameNode) 192.168.88.253:5070

- 0.0.0.0:50090 第二數(shù)據(jù)名稱節(jié)點(diǎn)(SecondaryNameNode) 192.168.88.129:50090

- 0.0.0.0:50060 任務(wù)執(zhí)行節(jié)點(diǎn)(TaskTracker) 192.168.88.130:5060

- 0.0.0.0:50075 數(shù)據(jù)節(jié)點(diǎn)(DataNode) 192.168.88.130:5075

下圖是之前執(zhí)行計(jì)算時(shí)筆者的截圖: