2012年11月14日 #

下載后,直接用 Scala IDE 通過已存在的項(xiàng)目導(dǎo)入到Eclipse workspace中去,然后Eclipse會自動進(jìn)行編譯。第一次編譯會報很多錯誤,不過總的來說,導(dǎo)致編譯錯誤的源頭有三個:

1、Scala編譯器版本錯誤

2、Eclipse Maven插件不能自動識別spark project的一些pom,報Plugin execution not covered by lifecycle configuration異常

3、一些項(xiàng)目,maven會自動生成scala和java文件,但是這些自動生成的代碼文件沒有配置在eclipse項(xiàng)目的classpath里。

針對第一種錯誤,比較簡單,對于每個scala項(xiàng)目,右鍵屬性選擇spark對應(yīng)的scala編譯器版本。

當(dāng)然spark代碼里的項(xiàng)目有幾十個,只能手工一個個設(shè)置了,比較傻,沒辦法,還不停的彈出對話框,不停地回車吧。

編譯的難點(diǎn)主要在第二種錯誤上,比如spark-sql項(xiàng)目的pom, 里面有個build-helper-maven-plugin,它下面的execution,eclipse maven插件無法識別,報Plugin execution not covered by lifecycle configuration異常,解決方案參見 https://www.eclipse.org/m2e/documentation/m2e-execution-not-covered.html,先使用 Eclipse quick-fix選項(xiàng)自動修復(fù),忽略此 maven goal,Eclipse 會為 pom.xml自動添加一段xml代碼,包含在 pluginManagement section中,里面有一段 <action><ignore/></action>,此處手動修改成

<execute>

<runOnIncremental>false</runOnIncremental>

</execute>

</action>

一共有5個project需要修改pom,如圖

修改pom后重新編譯,依舊會報一些錯誤,這些錯誤都是由于maven自動生成的java和scala代碼沒有添加到classpath里導(dǎo)致的編譯錯誤,只需要手工添加一下即可,需要手工添加項(xiàng)目有 spark-streaming-flume-sink 的 src_managed\main\compiled_avro 目錄 和 spark-sql 項(xiàng)目的 test\gen-java 目錄。

全部編譯好以后的截圖:

修改完以后,Spark代碼全部編譯下來大概耗時25分鐘左右(CPU 雙核 I7 4600)

原文地址:http://www.aygfsteel.com/cnfree/archive/2016/11/08/431965.html

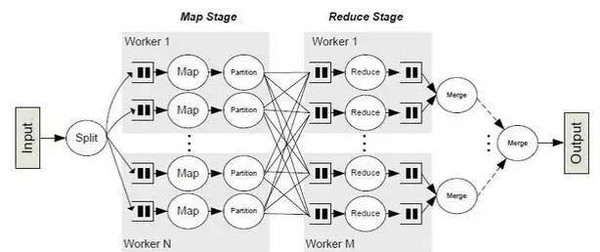

Spark簡介

Spark是整個BDAS的核心組件,是一個大數(shù)據(jù)分布式編程框架,不僅實(shí)現(xiàn)了MapReduce的算子map 函數(shù)和reduce函數(shù)及計(jì)算模型,還提供更為豐富的算子,如filter、join、groupByKey等。是一個用來實(shí)現(xiàn)快速而同用的集群計(jì)算的平臺。

Spark將分布式數(shù)據(jù)抽象為彈性分布式數(shù)據(jù)集(RDD),實(shí)現(xiàn)了應(yīng)用任務(wù)調(diào)度、RPC、序列化和壓縮,并為運(yùn)行在其上的上層組件提供API。其底層采用Scala這種函數(shù)式語言書寫而成,并且所提供的API深度借鑒Scala函數(shù)式的編程思想,提供與Scala類似的編程接口

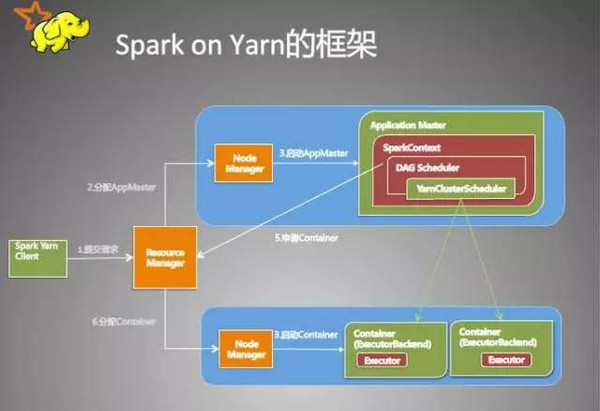

Sparkon Yarn

從用戶提交作業(yè)到作業(yè)運(yùn)行結(jié)束整個運(yùn)行期間的過程分析。

一、客戶端進(jìn)行操作

根據(jù)yarnConf來初始化yarnClient,并啟動yarnClient

創(chuàng)建客戶端Application,并獲取Application的ID,進(jìn)一步判斷集群中的資源是否滿足executor和ApplicationMaster申請的資源,如果不滿足則拋出IllegalArgumentException;

設(shè)置資源、環(huán)境變量:其中包括了設(shè)置Application的Staging目錄、準(zhǔn)備本地資源(jar文件、log4j.properties)、設(shè)置Application其中的環(huán)境變量、創(chuàng)建Container啟動的Context等;

設(shè)置Application提交的Context,包括設(shè)置應(yīng)用的名字、隊(duì)列、AM的申請的Container、標(biāo)記該作業(yè)的類型為Spark;

申請Memory,并最終通過yarnClient.submitApplication向ResourceManager提交該Application。

當(dāng)作業(yè)提交到Y(jié)ARN上之后,客戶端就沒事了,甚至在終端關(guān)掉那個進(jìn)程也沒事,因?yàn)檎麄€作業(yè)運(yùn)行在YARN集群上進(jìn)行,運(yùn)行的結(jié)果將會保存到HDFS或者日志中。

二、提交到Y(jié)ARN集群,YARN操作

運(yùn)行ApplicationMaster的run方法;

設(shè)置好相關(guān)的環(huán)境變量。

創(chuàng)建amClient,并啟動;

在Spark UI啟動之前設(shè)置Spark UI的AmIpFilter;

在startUserClass函數(shù)專門啟動了一個線程(名稱為Driver的線程)來啟動用戶提交的Application,也就是啟動了Driver。在Driver中將會初始化SparkContext;

等待SparkContext初始化完成,最多等待spark.yarn.applicationMaster.waitTries次數(shù)(默認(rèn)為10),如果等待了的次數(shù)超過了配置的,程序?qū)顺觯环駝t用SparkContext初始化yarnAllocator;

當(dāng)SparkContext、Driver初始化完成的時候,通過amClient向ResourceManager注冊ApplicationMaster

分配并啟動Executeors。在啟動Executeors之前,先要通過yarnAllocator獲取到numExecutors個Container,然后在Container中啟動Executeors。

那么這個Application將失敗,將Application Status標(biāo)明為FAILED,并將關(guān)閉SparkContext。其實(shí),啟動Executeors是通過ExecutorRunnable實(shí)現(xiàn)的,而ExecutorRunnable內(nèi)部是啟動CoarseGrainedExecutorBackend的。

最后,Task將在CoarseGrainedExecutorBackend里面運(yùn)行,然后運(yùn)行狀況會通過Akka通知CoarseGrainedScheduler,直到作業(yè)運(yùn)行完成。

Spark節(jié)點(diǎn)的概念

一、Spark驅(qū)動器是執(zhí)行程序中的main()方法的進(jìn)程。它執(zhí)行用戶編寫的用來創(chuàng)建SparkContext(初始化)、創(chuàng)建RDD,以及運(yùn)行RDD的轉(zhuǎn)化操作和行動操作的代碼。

驅(qū)動器節(jié)點(diǎn)driver的職責(zé):

把用戶程序轉(zhuǎn)為任務(wù)task(driver)

Spark驅(qū)動器程序負(fù)責(zé)把用戶程序轉(zhuǎn)化為多個物理執(zhí)行單元,這些單元也被稱之為任務(wù)task(詳解見備注)

為執(zhí)行器節(jié)點(diǎn)調(diào)度任務(wù)(executor)

有了物理計(jì)劃之后,Spark驅(qū)動器在各個執(zhí)行器節(jié)點(diǎn)進(jìn)程間協(xié)調(diào)任務(wù)的調(diào)度。Spark驅(qū)動器程序會根據(jù)當(dāng)前的執(zhí)行器節(jié)點(diǎn),把所有任務(wù)基于數(shù)據(jù)所在位置分配給合適的執(zhí)行器進(jìn)程。當(dāng)執(zhí)行任務(wù)時,執(zhí)行器進(jìn)程會把緩存的數(shù)據(jù)存儲起來,而驅(qū)動器進(jìn)程同樣會跟蹤這些緩存數(shù)據(jù)的位置,并利用這些位置信息來調(diào)度以后的任務(wù),以盡量減少數(shù)據(jù)的網(wǎng)絡(luò)傳輸。(就是所謂的移動計(jì)算,而不移動數(shù)據(jù))。

二、執(zhí)行器節(jié)點(diǎn)

作用:

負(fù)責(zé)運(yùn)行組成Spark應(yīng)用的任務(wù),并將結(jié)果返回給驅(qū)動器進(jìn)程;

通過自身的塊管理器(blockManager)為用戶程序中要求緩存的RDD提供內(nèi)存式存儲。RDD是直接緩存在執(zhí)行器進(jìn)程內(nèi)的,因此任務(wù)可以在運(yùn)行時充分利用緩存數(shù)據(jù)加快運(yùn)算。

驅(qū)動器的職責(zé):

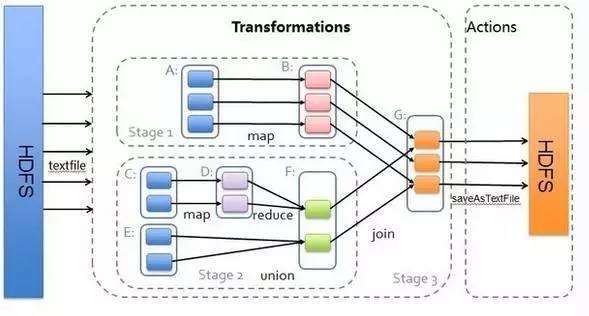

所有的Spark程序都遵循同樣的結(jié)構(gòu):程序從輸入數(shù)據(jù)創(chuàng)建一系列RDD,再使用轉(zhuǎn)化操作派生成新的RDD,最后使用行動操作手機(jī)或存儲結(jié)果RDD,Spark程序其實(shí)是隱式地創(chuàng)建出了一個由操作組成的邏輯上的有向無環(huán)圖DAG。當(dāng)驅(qū)動器程序執(zhí)行時,它會把這個邏輯圖轉(zhuǎn)為物理執(zhí)行計(jì)劃。

這樣 Spark就把邏輯計(jì)劃轉(zhuǎn)為一系列步驟(stage),而每個步驟又由多個任務(wù)組成。這些任務(wù)會被打包送到集群中。

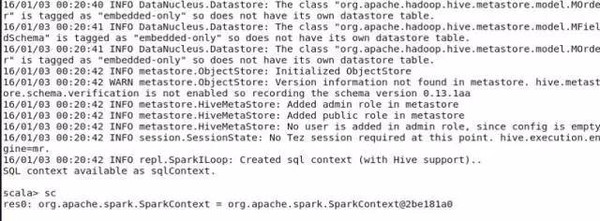

Spark初始化

每個Spark應(yīng)用都由一個驅(qū)動器程序來發(fā)起集群上的各種并行操作。驅(qū)動器程序包含應(yīng)用的main函數(shù),并且定義了集群上的分布式數(shù)據(jù)集,以及對該分布式數(shù)據(jù)集應(yīng)用了相關(guān)操作。

驅(qū)動器程序通過一個SparkContext對象來訪問spark,這個對象代表對計(jì)算集群的一個連接。(比如在sparkshell啟動時已經(jīng)自動創(chuàng)建了一個SparkContext對象,是一個叫做SC的變量。(下圖,查看變量sc)

一旦創(chuàng)建了sparkContext,就可以用它來創(chuàng)建RDD。比如調(diào)用sc.textFile()來創(chuàng)建一個代表文本中各行文本的RDD。(比如vallinesRDD = sc.textFile(“yangsy.text”),val spark = linesRDD.filter(line=>line.contains(“spark”),spark.count())

執(zhí)行這些操作,驅(qū)動器程序一般要管理多個執(zhí)行器,就是我們所說的executor節(jié)點(diǎn)。

在初始化SparkContext的同時,加載sparkConf對象來加載集群的配置,從而創(chuàng)建sparkContext對象。

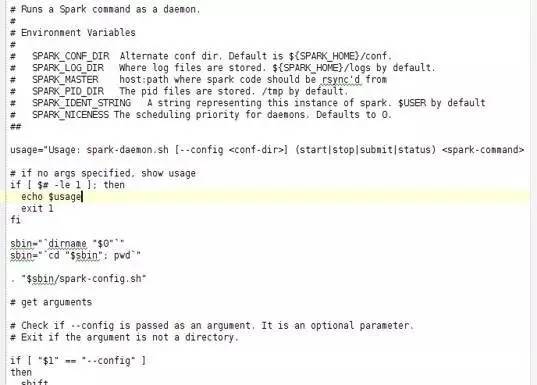

從源碼中可以看到,在啟動thriftserver時,調(diào)用了spark- daemon.sh文件,該文件源碼如左圖,加載spark_home下的conf中的文件。

(在執(zhí)行后臺代碼時,需要首先創(chuàng)建conf對象,加載相應(yīng)參數(shù), val sparkConf = newSparkConf().setMaster("local").setAppName("cocapp").set("spark.executor.memory","1g"), val sc: SparkContext = new SparkContext(sparkConf))

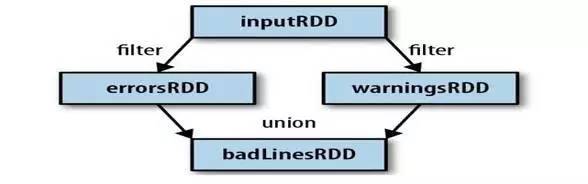

RDD工作原理:

RDD(Resilient DistributedDatasets)[1] ,彈性分布式數(shù)據(jù)集,是分布式內(nèi)存的一個抽象概念,RDD提供了一種高度受限的共享內(nèi)存模型,即RDD是只讀的記錄分區(qū)的集合,只能通過在其他RDD執(zhí)行確定的轉(zhuǎn)換操作(如map、join和group by)而創(chuàng)建,然而這些限制使得實(shí)現(xiàn)容錯的開銷很低。對開發(fā)者而言,RDD可以看作是Spark的一個對象,它本身運(yùn)行于內(nèi)存中,如讀文件是一個RDD,對文件計(jì)算是一個RDD,結(jié)果集也是一個RDD ,不同的分片、數(shù)據(jù)之間的依賴、key-value類型的map數(shù)據(jù)都可以看做RDD。

主要分為三部分:創(chuàng)建RDD對象,DAG調(diào)度器創(chuàng)建執(zhí)行計(jì)劃,Task調(diào)度器分配任務(wù)并調(diào)度Worker開始運(yùn)行。

SparkContext(RDD相關(guān)操作)→通過(提交作業(yè))→(遍歷RDD拆分stage→生成作業(yè))DAGScheduler→通過(提交任務(wù)集)→任務(wù)調(diào)度管理(TaskScheduler)→通過(按照資源獲取任務(wù))→任務(wù)調(diào)度管理(TaskSetManager)

Transformation返回值還是一個RDD。它使用了鏈?zhǔn)秸{(diào)用的設(shè)計(jì)模式,對一個RDD進(jìn)行計(jì)算后,變換成另外一個RDD,然后這個RDD又可以進(jìn)行另外一次轉(zhuǎn)換。這個過程是分布式的。

Action返回值不是一個RDD。它要么是一個Scala的普通集合,要么是一個值,要么是空,最終或返回到Driver程序,或把RDD寫入到文件系統(tǒng)中

轉(zhuǎn)換(Transformations)(如:map, filter, groupBy, join等),Transformations操作是Lazy的,也就是說從一個RDD轉(zhuǎn)換生成另一個RDD的操作不是馬上執(zhí)行,Spark在遇到Transformations操作時只會記錄需要這樣的操作,并不會去執(zhí)行,需要等到有Actions操作的時候才會真正啟動計(jì)算過程進(jìn)行計(jì)算。

操作(Actions)(如:count, collect, save等),Actions操作會返回結(jié)果或把RDD數(shù)據(jù)寫到存儲系統(tǒng)中。Actions是觸發(fā)Spark啟動計(jì)算的動因。

它們本質(zhì)區(qū)別是:Transformation返回值還是一個RDD。它使用了鏈?zhǔn)秸{(diào)用的設(shè)計(jì)模式,對一個RDD進(jìn)行計(jì)算后,變換成另外一個RDD,然后這個RDD又可以進(jìn)行另外一次轉(zhuǎn)換。這個過程是分布式的。Action返回值不是一個RDD。它要么是一個Scala的普通集合,要么是一個值,要么是空,最終或返回到Driver程序,或把RDD寫入到文件系統(tǒng)中。關(guān)于這兩個動作,在Spark開發(fā)指南中會有就進(jìn)一步的詳細(xì)介紹,它們是基于Spark開發(fā)的核心。

RDD基礎(chǔ)

Spark中的RDD就是一個不可變的分布式對象集合。每個RDD都被分為多個分區(qū),這些分區(qū)運(yùn)行在集群的不同節(jié)點(diǎn)上。創(chuàng)建RDD的方法有兩種:一種是讀取一個外部數(shù)據(jù)集;一種是在群東程序里分發(fā)驅(qū)動器程序中的對象集合,不如剛才的示例,讀取文本文件作為一個字符串的RDD的示例。

創(chuàng)建出來后,RDD支持兩種類型的操作:轉(zhuǎn)化操作和行動操作

轉(zhuǎn)化操作會由一個RDD生成一個新的RDD。(比如剛才的根據(jù)謂詞篩選)

行動操作會對RDD計(jì)算出一個結(jié)果,并把結(jié)果返回到驅(qū)動器程序中,或把結(jié)果存儲到外部存儲系統(tǒng)(比如HDFS)中。比如first()操作就是一個行動操作,會返回RDD的第一個元素。

注:轉(zhuǎn)化操作與行動操作的區(qū)別在于Spark計(jì)算RDD的方式不同。雖然你可以在任何時候定義一個新的RDD,但Spark只會惰性計(jì)算這些RDD。它們只有第一個在一個行動操作中用到時,才會真正的計(jì)算。之所以這樣設(shè)計(jì),是因?yàn)楸热鐒偛耪{(diào)用sc.textFile(...)時就把文件中的所有行都讀取并存儲起來,就會消耗很多存儲空間,而我們馬上又要篩選掉其中的很多數(shù)據(jù)。

這里還需要注意的一點(diǎn)是,spark會在你每次對它們進(jìn)行行動操作時重新計(jì)算。如果想在多個行動操作中重用同一個RDD,那么可以使用RDD.persist()或RDD.collect()讓Spark把這個RDD緩存下來。(可以是內(nèi)存,也可以是磁盤)

Spark會使用譜系圖來記錄這些不同RDD之間的依賴關(guān)系,Spark需要用這些信息來按需計(jì)算每個RDD,也可以依靠譜系圖在持久化的RDD丟失部分?jǐn)?shù)據(jù)時用來恢復(fù)所丟失的數(shù)據(jù)。(如下圖,過濾errorsRDD與warningsRDD,最終調(diào)用union()函數(shù))

RDD計(jì)算方式

RDD的寬窄依賴

窄依賴 (narrowdependencies) 和寬依賴 (widedependencies) 。窄依賴是指 父 RDD 的每個分區(qū)都只被子 RDD 的一個分區(qū)所使用 。相應(yīng)的,那么寬依賴就是指父 RDD 的分區(qū)被多個子 RDD 的分區(qū)所依賴。例如, map 就是一種窄依賴,而 join 則會導(dǎo)致寬依賴

這種劃分有兩個用處。首先,窄依賴支持在一個結(jié)點(diǎn)上管道化執(zhí)行。例如基于一對一的關(guān)系,可以在 filter 之后執(zhí)行 map 。其次,窄依賴支持更高效的故障還原。因?yàn)閷τ谡蕾嚕挥衼G失的父 RDD 的分區(qū)需要重新計(jì)算。而對于寬依賴,一個結(jié)點(diǎn)的故障可能導(dǎo)致來自所有父 RDD 的分區(qū)丟失,因此就需要完全重新執(zhí)行。因此對于寬依賴,Spark 會在持有各個父分區(qū)的結(jié)點(diǎn)上,將中間數(shù)據(jù)持久化來簡化故障還原,就像 MapReduce 會持久化 map 的輸出一樣。

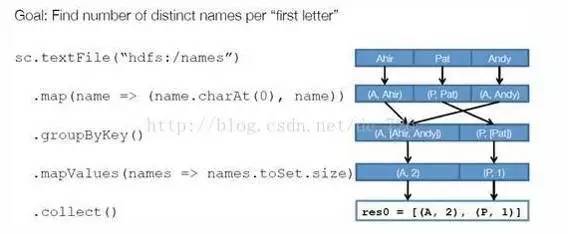

SparkExample

步驟 1 :創(chuàng)建 RDD 。上面的例子除去最后一個 collect 是個動作,不會創(chuàng)建 RDD 之外,前面四個轉(zhuǎn)換都會創(chuàng)建出新的 RDD 。因此第一步就是創(chuàng)建好所有 RDD( 內(nèi)部的五項(xiàng)信息 ) 。

步驟 2 :創(chuàng)建執(zhí)行計(jì)劃。Spark 會盡可能地管道化,并基于是否要重新組織數(shù)據(jù)來劃分 階段 (stage) ,例如本例中的 groupBy() 轉(zhuǎn)換就會將整個執(zhí)行計(jì)劃劃分成兩階段執(zhí)行。最終會產(chǎn)生一個 DAG(directedacyclic graph ,有向無環(huán)圖 ) 作為邏輯執(zhí)行計(jì)劃。

步驟 3 :調(diào)度任務(wù)。 將各階段劃分成不同的 任務(wù) (task) ,每個任務(wù)都是數(shù)據(jù)和計(jì)算的合體。在進(jìn)行下一階段前,當(dāng)前階段的所有任務(wù)都要執(zhí)行完成。因?yàn)橄乱浑A段的第一個轉(zhuǎn)換一定是重新組織數(shù)據(jù)的,所以必須等當(dāng)前階段所有結(jié)果數(shù)據(jù)都計(jì)算出來了才能繼續(xù)。

假設(shè)本例中的 hdfs://names 下有四個文件塊,那么 HadoopRDD 中 partitions 就會有四個分區(qū)對應(yīng)這四個塊數(shù)據(jù),同時 preferedLocations 會指明這四個塊的最佳位置。現(xiàn)在,就可以創(chuàng)建出四個任務(wù),并調(diào)度到合適的集群結(jié)點(diǎn)上。

Spark數(shù)據(jù)分區(qū)

Spark的特性是對數(shù)據(jù)集在節(jié)點(diǎn)間的分區(qū)進(jìn)行控制。在分布式系統(tǒng)中,通訊的代價是巨大的,控制數(shù)據(jù)分布以獲得最少的網(wǎng)絡(luò)傳輸可以極大地提升整體性能。Spark程序可以通過控制RDD分區(qū)方式來減少通訊的開銷。

Spark中所有的鍵值對RDD都可以進(jìn)行分區(qū)。確保同一組的鍵出現(xiàn)在同一個節(jié)點(diǎn)上。比如,使用哈希分區(qū)將一個RDD分成了100個分區(qū),此時鍵的哈希值對100取模的結(jié)果相同的記錄會被放在一個節(jié)點(diǎn)上。

(可使用partitionBy(newHashPartitioner(100)).persist()來構(gòu)造100個分區(qū))

Spark中的許多操作都引入了將數(shù)據(jù)根據(jù)鍵跨界點(diǎn)進(jìn)行混洗的過程。(比如:join(),leftOuterJoin(),groupByKey(),reducebyKey()等)對于像reduceByKey()這樣只作用于單個RDD的操作,運(yùn)行在未分區(qū)的RDD上的時候會導(dǎo)致每個鍵的所有對應(yīng)值都在每臺機(jī)器上進(jìn)行本地計(jì)算。

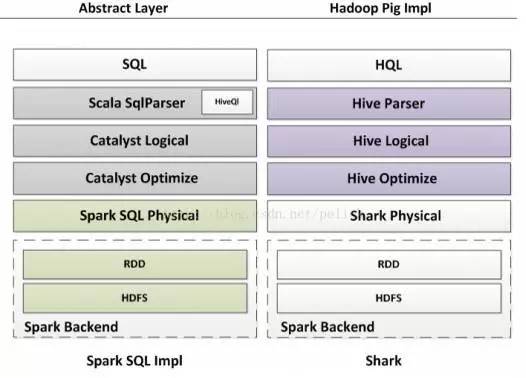

SparkSQL的shuffle過程

Spark SQL的核心是把已有的RDD,帶上Schema信息,然后注冊成類似sql里的”Table”,對其進(jìn)行sql查詢。這里面主要分兩部分,一是生成SchemaRD,二是執(zhí)行查詢。

如果是spark-hive項(xiàng)目,那么讀取metadata信息作為Schema、讀取hdfs上數(shù)據(jù)的過程交給Hive完成,然后根據(jù)這倆部分生成SchemaRDD,在HiveContext下進(jìn)行hql()查詢。

SparkSQL結(jié)構(gòu)化數(shù)據(jù)

首先說一下ApacheHive,Hive可以在HDFS內(nèi)或者在其他存儲系統(tǒng)上存儲多種格式的表。SparkSQL可以讀取Hive支持的任何表。要把Spark SQL連接已有的hive上,需要提供Hive的配置文件。hive-site.xml文件復(fù)制到spark的conf文件夾下。再創(chuàng)建出HiveContext對象(sparksql的入口),然后就可以使用HQL來對表進(jìn)行查詢,并以由行足證的RDD的形式拿到返回的數(shù)據(jù)。

創(chuàng)建Hivecontext并查詢數(shù)據(jù)

importorg.apache.spark.sql.hive.HiveContext

valhiveCtx = new org.apache.spark.sql.hive.HiveContext(sc)

valrows = hiveCtx.sql(“SELECT name,age FROM users”)

valfitstRow – rows.first()

println(fitstRow.getSgtring(0)) //字段0是name字段

通過jdbc連接外部數(shù)據(jù)源更新與加載

Class.forName("com.mysql.jdbc.Driver")

val conn =DriverManager.getConnection(mySQLUrl)

val stat1 =conn.createStatement()

stat1.execute("UPDATE CI_LABEL_INFO set DATA_STATUS_ID = 2 , DATA_DATE ='" + dataDate +"' where LABEL_ID in ("+allCreatedLabels.mkString(",")+")")

stat1.close()

//加載外部數(shù)據(jù)源數(shù)據(jù)到內(nèi)存

valDIM_COC_INDEX_MODEL_TABLE_CONF =sqlContext.jdbc(mySQLUrl,"DIM_COC_INDEX_MODEL_TABLE_CONF").cache()

val targets =DIM_COC_INDEX_MODEL_TABLE_CONF.filter("TABLE_DATA_CYCLE ="+TABLE_DATA_CYCLE).collect

SparkSQL解析

首先說下傳統(tǒng)數(shù)據(jù)庫的解析,傳統(tǒng)數(shù)據(jù)庫的解析過程是按Rusult、Data Source、Operation的次序來解析的。傳統(tǒng)數(shù)據(jù)庫先將讀入的SQL語句進(jìn)行解析,分辨出SQL語句中哪些詞是關(guān)鍵字(如select,from,where),哪些是表達(dá)式,哪些是Projection,哪些是Data Source等等。進(jìn)一步判斷SQL語句是否規(guī)范,不規(guī)范就報錯,規(guī)范則按照下一步過程綁定(Bind)。過程綁定是將SQL語句和數(shù)據(jù)庫的數(shù)據(jù)字典(列,表,視圖等)進(jìn)行綁定,如果相關(guān)的Projection、Data Source等都存在,就表示這個SQL語句是可以執(zhí)行的。在執(zhí)行過程中,有時候甚至不需要讀取物理表就可以返回結(jié)果,比如重新運(yùn)行剛運(yùn)行過的SQL語句,直接從數(shù)據(jù)庫的緩沖池中獲取返回結(jié)果。在數(shù)據(jù)庫解析的過程中SQL語句時,將會把SQL語句轉(zhuǎn)化成一個樹形結(jié)構(gòu)來進(jìn)行處理,會形成一個或含有多個節(jié)點(diǎn)(TreeNode)的Tree,然后再后續(xù)的處理政對該Tree進(jìn)行一系列的操作。

Spark SQL對SQL語句的處理和關(guān)系數(shù)據(jù)庫對SQL語句的解析采用了類似的方法,首先會將SQL語句進(jìn)行解析,然后形成一個Tree,后續(xù)如綁定、優(yōu)化等處理過程都是對Tree的操作,而操作方法是采用Rule,通過模式匹配,對不同類型的節(jié)點(diǎn)采用不同的操作。SparkSQL有兩個分支,sqlContext和hiveContext。sqlContext現(xiàn)在只支持SQL語法解析器(Catalyst),hiveContext支持SQL語法和HiveContext語法解析器。

原文地址:http://mt.sohu.com/20160522/n450849016.shtml

spark中有partition的概念(和slice是同一個概念,在spark1.2中官網(wǎng)已經(jīng)做出了說明),一般每個partition對應(yīng)一個task。在我的測試過程中,如果沒有設(shè)置spark.default.parallelism參數(shù),spark計(jì)算出來的partition非常巨大,與我的cores非常不搭。我在兩臺機(jī)器上(8cores *2 +6g * 2)上,spark計(jì)算出來的partition達(dá)到2.8萬個,也就是2.9萬個tasks,每個task完成時間都是幾毫秒或者零點(diǎn)幾毫秒,執(zhí)行起來非常緩慢。在我嘗試設(shè)置了 spark.default.parallelism 后,任務(wù)數(shù)減少到10,執(zhí)行一次計(jì)算過程從minute降到20second。

參數(shù)可以通過spark_home/conf/spark-default.conf配置文件設(shè)置。

eg.

spark.master spark://master:7077

spark.default.parallelism 10

spark.driver.memory 2g

spark.serializer org.apache.spark.serializer.KryoSerializer

spark.sql.shuffle.partitions 50

下面是官網(wǎng)的相關(guān)描述:

from:http://spark.apache.org/docs/latest/configuration.html

| Property Name | Default | Meaning |

|---|---|---|

spark.default.parallelism |

For distributed shuffle operations like reduceByKey and join, the largest number of partitions in a parent RDD. For operations likeparallelize with no parent RDDs, it depends on the cluster manager:

|

Default number of partitions in RDDs returned by transformations like join, reduceByKey, and parallelize when not set by user. |

from:http://spark.apache.org/docs/latest/tuning.html

Level of Parallelism

Clusters will not be fully utilized unless you set the level of parallelism for each operation high enough. Spark automatically sets the number of “map” tasks to run on each file according to its size (though you can control it through optional parameters to SparkContext.textFile, etc), and for distributed “reduce” operations, such as groupByKey and reduceByKey, it uses the largest parent RDD’s number of partitions. You can pass the level of parallelism as a second argument (see the spark.PairRDDFunctions documentation), or set the config propertyspark.default.parallelism to change the default. In general, we recommend 2-3 tasks per CPU core in your cluster.

原文地址:http://www.cnblogs.com/wrencai/p/4231966.html

同時還提供了在線自動查找源代碼,查看Class二進(jìn)制字節(jié)碼的功能。

Eclipse Class Decompiler對JDK的最低要求為JDK1.6, 能反編譯和debug各版本的Class文件,支持JDK8的Lambda語法,同時支持中文等非Ascii碼字符集的解析,支持Eclipse 3.6及以上所有版本的Eclipse。

本插件支持Windows,Linux,Macosx 32位及64位操作系統(tǒng)。

Github項(xiàng)目地址為:https://github.com/cnfree/Eclipse-Class-Decompiler

請通過以下地址選擇一個可用的源在線安裝:

http://cnfree.github.io/Eclipse-Class-Decompiler/update

http://raw.githubusercontent.com/cnfree/eclipse/master/decompiler/update/

http://www.cpupk.com/decompiler/update/

離線包下載地址:

插件使用說明:

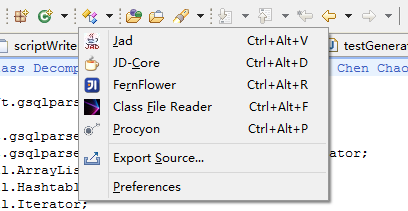

下圖為Eclipse Class Decompiler的首選項(xiàng)頁面,可以選擇缺省的反編譯器工具,并進(jìn)行反編譯器的基本設(shè)置。缺省的反編譯工具為JD-Core,JD-Core更為先進(jìn)一些,支持泛型、Enum、注解等JDK1.5以后才有的新語法。

首選項(xiàng)配置選項(xiàng):

1.重用緩存代碼:只會反編譯一次,以后每次打開該類文件,都顯示的是緩存的反編譯代碼。

2.忽略已存在的源代碼:若未選中,則查看Class文件是否已綁定了Java源代碼,如果已綁定,則顯示Java源代碼,如果未綁定,則反編譯Class文件。若選中此項(xiàng),則忽略已綁定的Java源代碼,顯示反編譯結(jié)果。

3.顯示反編譯器報告:顯示反編譯器反編譯后生成的數(shù)據(jù)報告及異常信息。

4.使用Eclipse代碼格式化工具:使用Eclipse格式化工具對反編譯結(jié)果重新格式化排版,反編譯整個Jar包時,此操作會消耗一些時間。

5.使用Eclipse成員排序:使用Eclipse成員排序?qū)Ψ淳幾g結(jié)果重新格式化排版,反編譯整個Jar包時,此操作會消耗大量時間。

6.以注釋方式輸出原始行號信息:如果Class文件包含原始行號信息,則會將行號信息以注釋的方式打印到反編譯結(jié)果中。

7.根據(jù)行號對齊源代碼以便于調(diào)試:若選中該項(xiàng),插件會采用AST工具分析反編譯結(jié)果,并根據(jù)行號信息調(diào)整代碼順序,以便于Debug過程中的單步跟蹤調(diào)試。

8.設(shè)置類反編譯查看器作為缺省的類文件編輯器:默認(rèn)為選中,將忽略Eclipse自帶的Class Viewer,每次Eclipse啟動后,默認(rèn)使用本插件提供的類查看器打開Class文件。

插件提供了系統(tǒng)菜單,工具欄,當(dāng)打開了插件提供的類反編譯查看器后,會激活菜單和工具欄選項(xiàng),可以方便的進(jìn)行首選項(xiàng)配置,切換反編譯工具重新反編譯,以及導(dǎo)出反編譯結(jié)果。

打開項(xiàng)目路徑下的Class文件,如果設(shè)置類反編譯查看器為缺省的查看器,直接雙擊Class文件即可,如果沒有設(shè)置為缺省查看器,可以使用右鍵菜單進(jìn)行查看。

同時插件也支持直接將外部的Class文件拖拽到Eclipse編輯器中進(jìn)行反編譯。

Eclipse Class Decompiler插件也提供了反編譯整個Jar文件或者Java包的反編譯。該操作支持Package Explorer對包顯示布局的操作,如果是平鋪模式布局,則導(dǎo)出的源代碼不包含子包,如果是層級模式布局,則導(dǎo)出選中的包及其所有的子包。

博文地址:http://www.aygfsteel.com/cnfree/archive/2012/10/30/390457.html

JCB是一個Java應(yīng)用,所以目標(biāo)機(jī)器上必須安裝1.5以上版本的JDK用以啟動JCB,但是JCB可以用來精簡1.4版的JRE,并且JRE1.4精簡后的體積遠(yuǎn)小于1.5以上的版本。

1.新建JCB項(xiàng)目

精簡JRE的步驟比較繁瑣,有可能精簡失敗,為了不重復(fù)之前的步驟,JCB提供一個項(xiàng)目文件用來保存精簡配置信息,擴(kuò)展名為jcprj。這里我們創(chuàng)建一個項(xiàng)目,名為JCB

Wizard需要輸入一個工程名和指定工程位置,至于下面的應(yīng)用程序位置和定制JRE位置由JCB自動指定,這兒顯示出來僅供參考。

此時最好Ctrl+S保存一下項(xiàng)目,否則退出后你之前的配置信息會全部丟失,因?yàn)槟悴]有制定一個可用的項(xiàng)目配置文件。

2. 配置JCB項(xiàng)目

首先指定項(xiàng)目需要的jar文件,然后依次選擇項(xiàng)目的main class,啟動路徑默認(rèn)為空,一般來說無需指定。然后設(shè)定應(yīng)用程序參數(shù)和虛擬機(jī)參數(shù)。最后選定需要精簡的JRE,JCB當(dāng)前支持1.4-1.7版本的JRE,未來可能會支持更高版本的JRE。

右下角有2個單選按鈕:全部重新運(yùn)行和增量運(yùn)行。全部重新運(yùn)行就會放棄之前的運(yùn)行結(jié)果,增量運(yùn)行就是會保留以前的運(yùn)行結(jié)果。

然后點(diǎn)擊“以Verbose模式運(yùn)行”按鈕。Verbose模式運(yùn)行Java程序,會顯示JVM加載的全部類信息,JCB需要這些類信息進(jìn)行JRE的精簡,所以請盡可能的把應(yīng)用所有的功能盡可能的跑一遍,跑的越全面,導(dǎo)致精簡出錯的可能性就越低。

Verbose運(yùn)行結(jié)果,這個頁面的顯示信息僅供參考,無實(shí)際用處。

3. 分析項(xiàng)目的類依賴項(xiàng)

分析類依賴模式有2個選項(xiàng):重新完全分析和增量分析。完全分析會花費(fèi)較多的時間。當(dāng)使用verbose模式增量運(yùn)行后,可以使用增量模式分析類依賴項(xiàng),這樣可以節(jié)約大量的時間。類依賴分析會反編譯所有運(yùn)行的類,分析類引用關(guān)系,但是無法獲取Class.forName這類動態(tài)類加載信息,所以需要Verbose模式運(yùn)行的盡量全面,以避免這些動態(tài)加載的類的缺失。

為什么需要分析類依賴關(guān)系呢?因?yàn)椴煌牟僮飨到y(tǒng),不同的硬件配置,JRE可能會采取策略模式加載不同的類,或者一些異常,Verbose模式一般不會加載,這樣換個硬件環(huán)境,僅僅使用Verbose模式的類可能會導(dǎo)致ClassNotFound這樣的異常,導(dǎo)致Java程序崩潰。

4. 精簡JRE

精簡JRE有兩種模式:使用Verbose運(yùn)行結(jié)果和使用類依賴分析結(jié)果。前者只包含Verbose分析出來的類,精簡出來的JRE包很小,但是基本不具備跨平臺性。所以一般來說推薦選擇后者。

如果你的程序包含Swing的客戶端,并且比較復(fù)雜的話,最好選中包含Swing選項(xiàng)。因?yàn)镾wing的設(shè)計(jì)完全是動態(tài)化的加載,全部使用Class.forName方式,類依賴分析對Swing是無效的。當(dāng)然選中該選項(xiàng)后,JRE的體積會增加許多。比較好的解決方案,是使用SWT替代Swing進(jìn)行開發(fā),或者盡量把你的程序跑全面,包括各種異常界面都跑出來。

右下角有兩個按鈕,是用來自定義類和資源文件的,比如移除JAR包的MD5文件或者無用的文件。或者測試運(yùn)行發(fā)現(xiàn)ClassNotFound異常,手動把缺少的類加進(jìn)去,然后JCB會自動運(yùn)行增量類依賴分析加載所有可能需要的類。

選擇左上角的“精簡Jar包”按鈕,就可以對JRE進(jìn)行精簡了,精簡完畢后可以點(diǎn)擊“查看精簡結(jié)果”按鈕進(jìn)行查看。

5.定制JRE

上圖顯示了JRE精簡結(jié)果,JCB會自動分析所有的Class,生成精簡版JRE,包括需要的JAR,DLL和資源文件。一般來說精簡出來的JRE,普通功能都能正確完成,但是不排除有些功能不能正常使用,比如缺少某個資源文件或者DLL,需要手工添加。

為了保證精簡的正確性,你需要進(jìn)行運(yùn)行測試,這一步是必須的,而且最好和Verbose運(yùn)行模式一樣,把所有的功能都跑一遍,確認(rèn)精簡無誤。

如果測試運(yùn)行有誤的話,請根據(jù)運(yùn)行錯誤報告進(jìn)行分析,如果缺少類,請使用Verbose模式重新運(yùn)行相應(yīng)的功能,或者在步驟四手工添加需要的類,然后重新生成依賴的JRE。如果缺少相關(guān)的DLL或者資源文件,也請手工添加,并且取消步驟四的“清理工作區(qū)選項(xiàng)”,否則每次精簡JRE都需要重新手工添加。

到此為止,精簡JRE部分就算全部完成了,你最好使用Ctrl+S保存一下結(jié)果,以避免下次重做項(xiàng)目。

JCB項(xiàng)目下載地址:http://www.sourceforge.net/projects/jcb

首先把這99個數(shù)分為10組,按高位為0-9分,然后計(jì)算每組的數(shù)量,數(shù)量最少的那個肯定就是缺失的那個,然后遞歸……找最少的那個,組合起來的數(shù)肯定是缺失的。答案是按位運(yùn)算找,和這個類似。

2. 43億個無符號整數(shù),找出一個重復(fù)的整數(shù)。也就是101個小于100的數(shù),找出重復(fù)的那個數(shù)來。

首先把這99個數(shù)分為10組,按高位為0-9分,然后計(jì)算每組的數(shù)量,數(shù)量最多的那組,肯定有重復(fù)的,一次類推找第二位……

When a object just uses a object, please use the association.

comparator

The typical decorator pattern is the java OutputStream, you can use the BufferedOutputStream to wrap it, then get the extra function.

The typical adapter pattern in the BIRT is the ElementAdapter, it can convert any object to an other object.

FlyWeight pattern extracts the same part of some different objects, and the part doesn't be changed when these objects changed. String class uses the FlyWeight pattern, jface ImageRegistry also uses it.

FlyWeight can have a interface to get external data, and change the external data's status, but FlyWeight internal status shouldn't be changed.

The Collections.sort() method implementation contains template method design pattern and strategy design pattern, but it doesn't contain the visitor design pattern. The Collections.sort() method uses the merge sort algorithm, you can't change it, but you can change the comparator logic, it's one step of the sort algorithm. So it's a template method pattern, but not a classic implementation, it uses the callback method to implement the pattern, but not extending the parent template class. The comparator class use the strategy design pattern, it not a visitor pattern, visitor pattern have a accept method to operate the element to deal some logic.